Effektiv PDF-tekst ekstraktion med Vision Language Models —— Hvorfor olmOCR ændrer spillet

OLMOCR Team

3. marts 2025

Billedtekst: olmOCRs end-to-end pipeline konverterer rodede PDF'er til struktureret Markdown-tekst til 1/32 af prisen for GPT-4o.

Billedtekst: olmOCRs end-to-end pipeline konverterer rodede PDF'er til struktureret Markdown-tekst til 1/32 af prisen for GPT-4o.

Den skjulte udfordring ved PDF'er: Hvorfor ren tekst er vigtig

Sprogmodeller trives med ren tekst – men PDF'er er den ultimative fjende. Designet til udskrivning, ikke parsing, roder de tekstpositioner, begraver tabeller i binær kode og forvandler ligninger til visuelle gåder. Traditionelle OCR-værktøjer? De går ofte glip af formatering, kæmper med layout med flere kolonner eller tager en formue.

Indtast olmOCR: et open source-værktøjssæt, der kombinerer vision-language models (VLMs) med smart engineering for at knække PDF-koden. Lad os nedbryde, hvorfor udviklere og forskere er begejstrede for det.

5 grunde til, at olmOCR overgår andre værktøjer

-

Omkostningseffektivitet, der er svær at ignorere

Behandl 1 million sider for $190 – det er 32x billigere end GPT-4o batch-API'er. Hvordan? Ved finjustering på 250K forskellige sider (akademiske artikler, juridiske dokumenter, endda håndskrevne breve) og optimering af inferens med SGLang/vLLM.

Behandl 1 million sider for $190 – det er 32x billigere end GPT-4o batch-API'er. Hvordan? Ved finjustering på 250K forskellige sider (akademiske artikler, juridiske dokumenter, endda håndskrevne breve) og optimering af inferens med SGLang/vLLM. -

Markdown-magi Ikke flere regex-mareridt. olmOCR udskriver ren Markdown med:

- Bevarede ligninger (

E=mc²) - Tabeller, der forbliver tabeller

- Korrekt læserækkefølge for komplekse layouts

- Bevarede ligninger (

-

Batterier inkluderet pipeline

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfSkaler problemfrit fra 1 til 100+ GPU'er. Indbygget fejlhåndtering tackler almindelige PDF-gremlins som metadata-korruption.

-

Open Source, nul sorte bokse Vægte, træningsdata (ja, alle 250K sider!) og kode er offentlige. Bygget på Qwen2-VL-7B-Instruct – ingen proprietære afhængigheder.

-

Menneskebevist overlegenhed

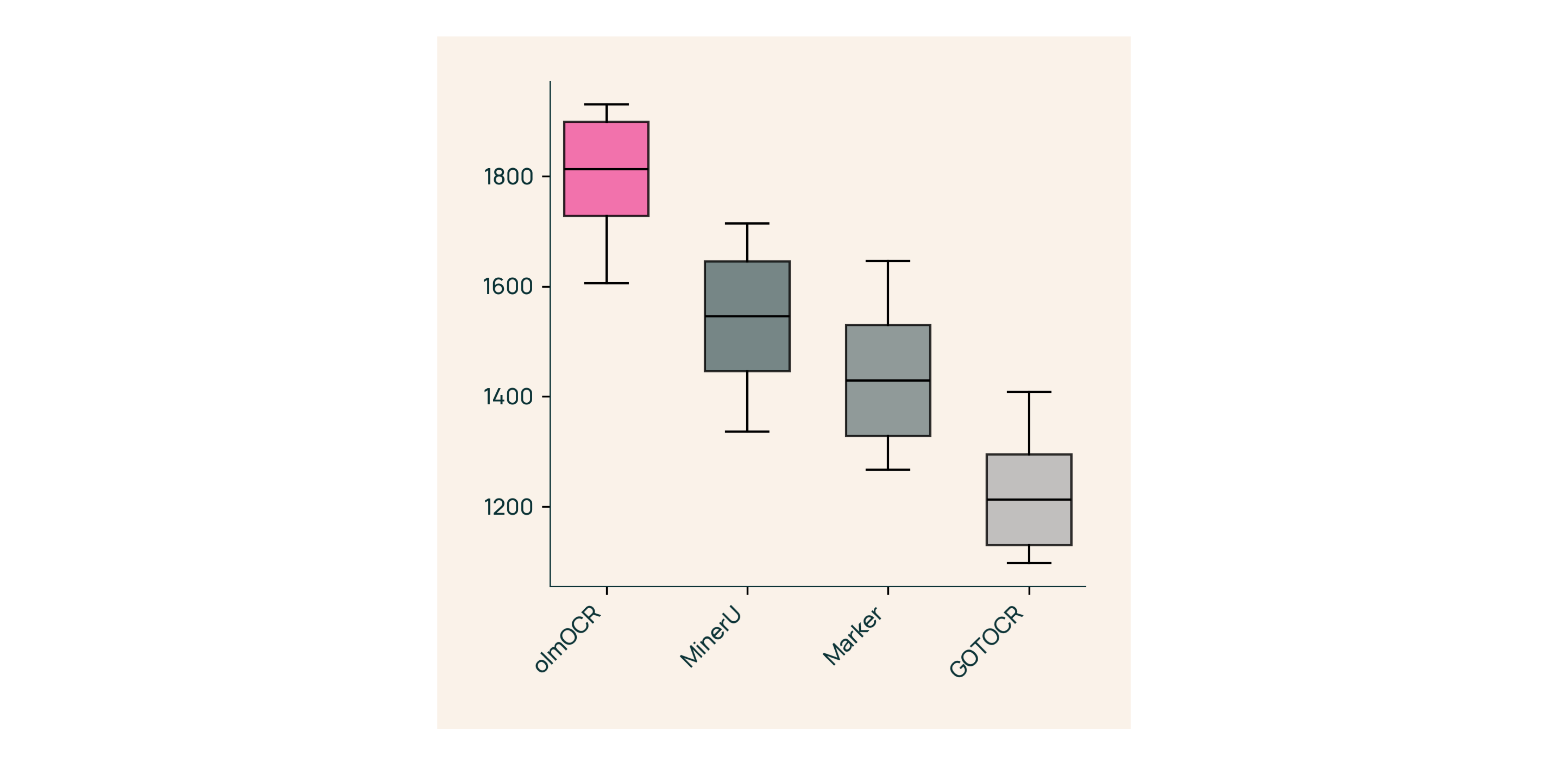

I blinde tests mod Marker, GOT-OCR 2.0 og MinerU:

I blinde tests mod Marker, GOT-OCR 2.0 og MinerU:- Vinder 61% af sammenligningerne

- Opnår ELO >1800 (Gold Standard)

Under motorhjelmen: Hvordan vi byggede olmOCR

Dokumentforankring: Hemmeligheden

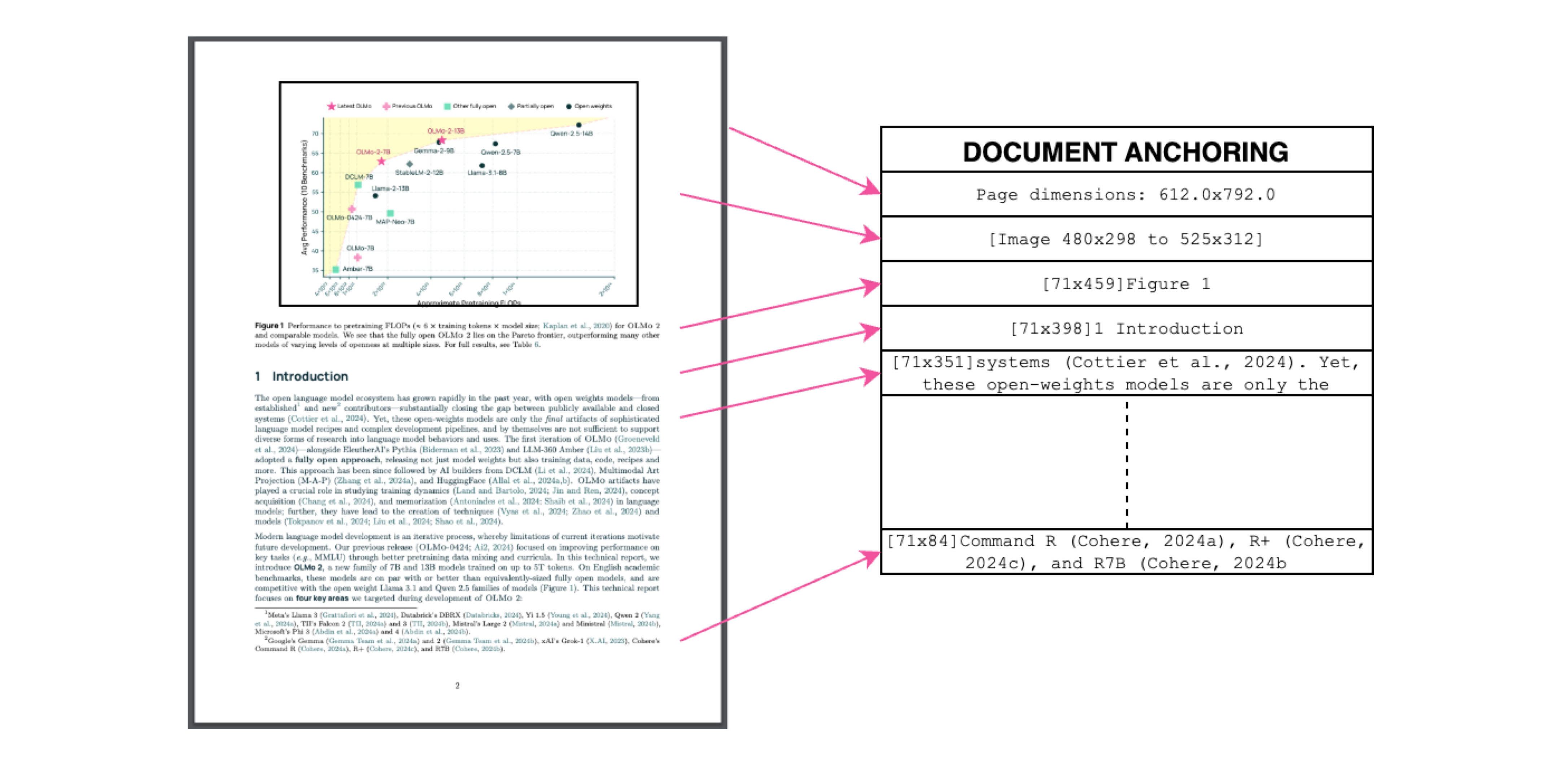

Billedtekst: Tekst + billedkontekst = præcis ekstraktion.

Billedtekst: Tekst + billedkontekst = præcis ekstraktion.

Vi bruger PDF'ers egen tekst/metadata til at "forankre" VLMs under træning:

- Udtræk tekstblokke og billedregioner

- Kombiner dem i modelprompter

- Lad GPT-4o generere "gold standard"-etiketter

Resultat? En model, der forstår både hvad tekst siger, og hvor den hører hjemme.

Træning til den virkelige verden

- Datasæt: 60% akademiske artikler, 12% brochurer, 11% juridiske dokumenter

- Hardware: Optimeret til NVIDIA GPU'er, 90% lavere energiforbrug end sammenlignelige opsætninger

- Finjustering: Qwen2-VL-7B-Instruct tilpasset til dokument "samtaler"

Prøv olmOCR på 3 minutter

- Installer

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Kør på eksempel PDF

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Tjek Markdown

Åbn

./demo_output/horribleocr.md– se tabeller, ligninger og tekstflow intakt!

Afsluttende bemærkning

olmOCR er ikke bare endnu et værktøj – det er et paradigmeskifte. Ved at kombinere VLMs med gennemsigtig engineering gør det højkvalitets tekstekstraktion tilgængelig for alle. Uanset om du bygger et forskningskorpus eller automatiserer fakturabehandling, hører dette værktøjssæt til i din stak.

Næste skridt

- ⭐ Stjern GitHub-repoet

- 📊 Sammenlign output ved hjælp af Interaktivt værktøj

- 💬 Deltag i diskussionen på Hugging Face

Lad os forvandle PDF-smerte til ren tekst-gevinst! 🚀