Effiziente PDF-Textextraktion mit Vision Language Models —— Warum olmOCR das Spiel verändert

OLMOCR Team

3. März 2025

Bildunterschrift: Die End-to-End-Pipeline von olmOCR wandelt unübersichtliche PDFs in strukturierten Markdown-Text um, und das zu einem Preis von 1/32 des Preises von GPT-4o.

Bildunterschrift: Die End-to-End-Pipeline von olmOCR wandelt unübersichtliche PDFs in strukturierten Markdown-Text um, und das zu einem Preis von 1/32 des Preises von GPT-4o.

Die versteckte Herausforderung von PDFs: Warum Klartext wichtig ist

Sprachmodelle gedeihen auf sauberem Text – aber PDFs sind der ultimative Feind in Freundesgestalt. Sie wurden zum Drucken und nicht zum Parsen entwickelt und vermischen Textpositionen, vergraben Tabellen in Binärcode und verwandeln Gleichungen in visuelle Rätsel. Traditionelle OCR-Tools? Sie übersehen oft die Formatierung, kämpfen mit mehrspaltigen Layouts oder sind extrem teuer.

Hier kommt olmOCR ins Spiel: ein Open-Source-Toolkit, das Vision-Language-Modelle (VLMs) mit cleverem Engineering kombiniert, um den PDF-Code zu knacken. Lassen Sie uns aufschlüsseln, warum Entwickler und Forscher davon begeistert sind.

5 Gründe, warum olmOCR andere Tools übertrifft

-

Kosteneffizienz, die man nicht ignorieren kann

Verarbeiten Sie 1 Million Seiten für 190 $ – das ist 32x günstiger als die Batch-APIs von GPT-4o. Wie? Durch Feintuning auf 250.000 verschiedenen Seiten (wissenschaftliche Arbeiten, juristische Dokumente, sogar handschriftliche Briefe) und Optimierung der Inferenz mit SGLang/vLLM.

Verarbeiten Sie 1 Million Seiten für 190 $ – das ist 32x günstiger als die Batch-APIs von GPT-4o. Wie? Durch Feintuning auf 250.000 verschiedenen Seiten (wissenschaftliche Arbeiten, juristische Dokumente, sogar handschriftliche Briefe) und Optimierung der Inferenz mit SGLang/vLLM. -

Markdown-Magie Keine Regex-Alpträume mehr. olmOCR gibt sauberes Markdown aus mit:

- Erhaltenen Gleichungen (

E=mc²) - Tabellen, die Tabellen bleiben

- Korrekter Lesereihenfolge für komplexe Layouts

- Erhaltenen Gleichungen (

-

Komplettpaket-Pipeline

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfSkalieren Sie nahtlos von 1 auf über 100 GPUs. Die integrierte Fehlerbehandlung bewältigt gängige PDF-Probleme wie Metadatenbeschädigung.

-

Open Source, keine Black Boxes Gewichte, Trainingsdaten (ja, alle 250.000 Seiten!) und Code sind öffentlich. Basierend auf Qwen2-VL-7B-Instruct – keine proprietären Abhängigkeiten.

-

Vom Menschen bewiesene Überlegenheit

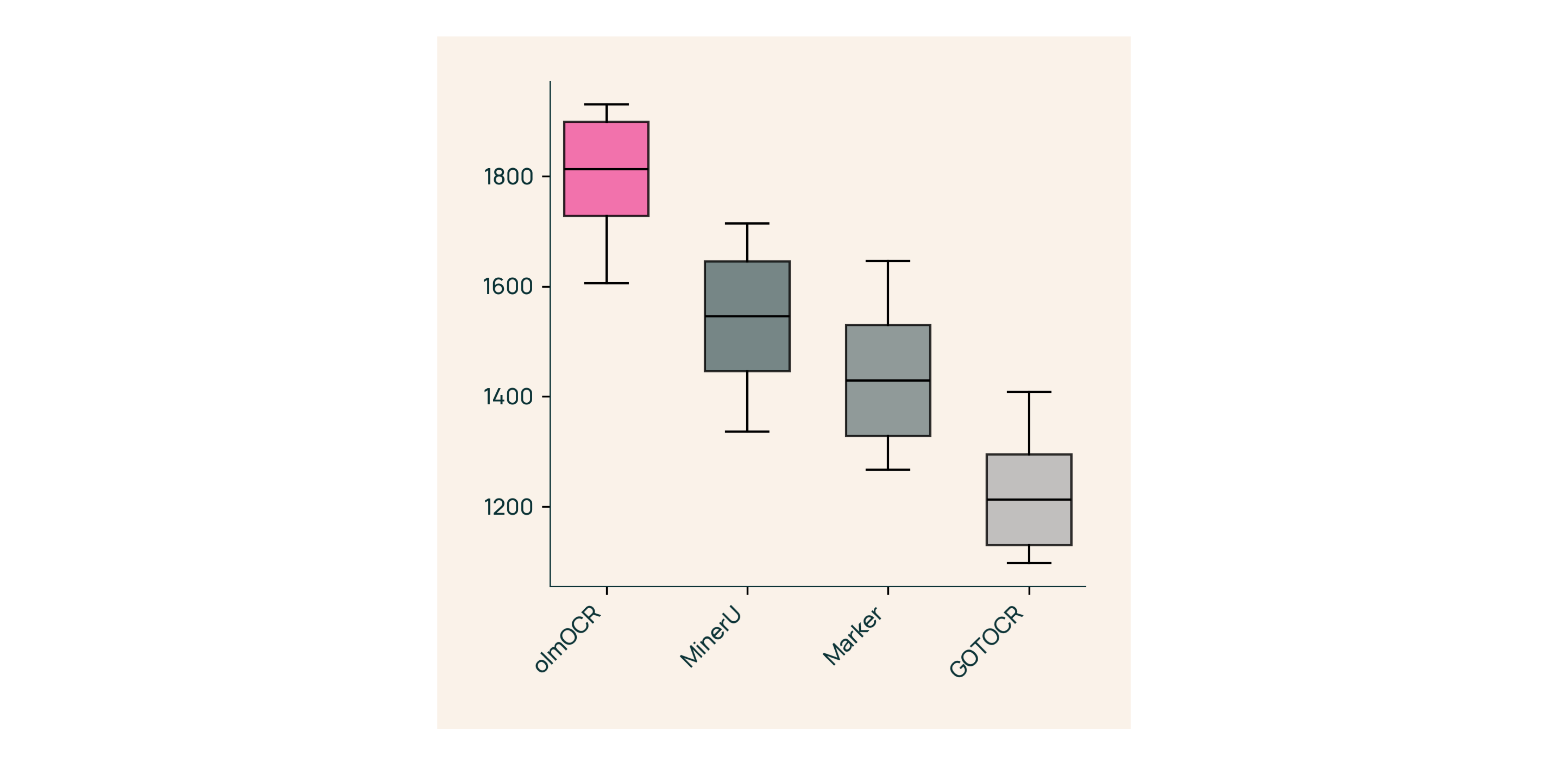

In Blindtests gegen Marker, GOT-OCR 2.0 und MinerU:

In Blindtests gegen Marker, GOT-OCR 2.0 und MinerU:- Gewinnt 61 % der Vergleiche

- Erreicht ELO >1800 (Goldstandard)

Unter der Haube: Wie wir olmOCR gebaut haben

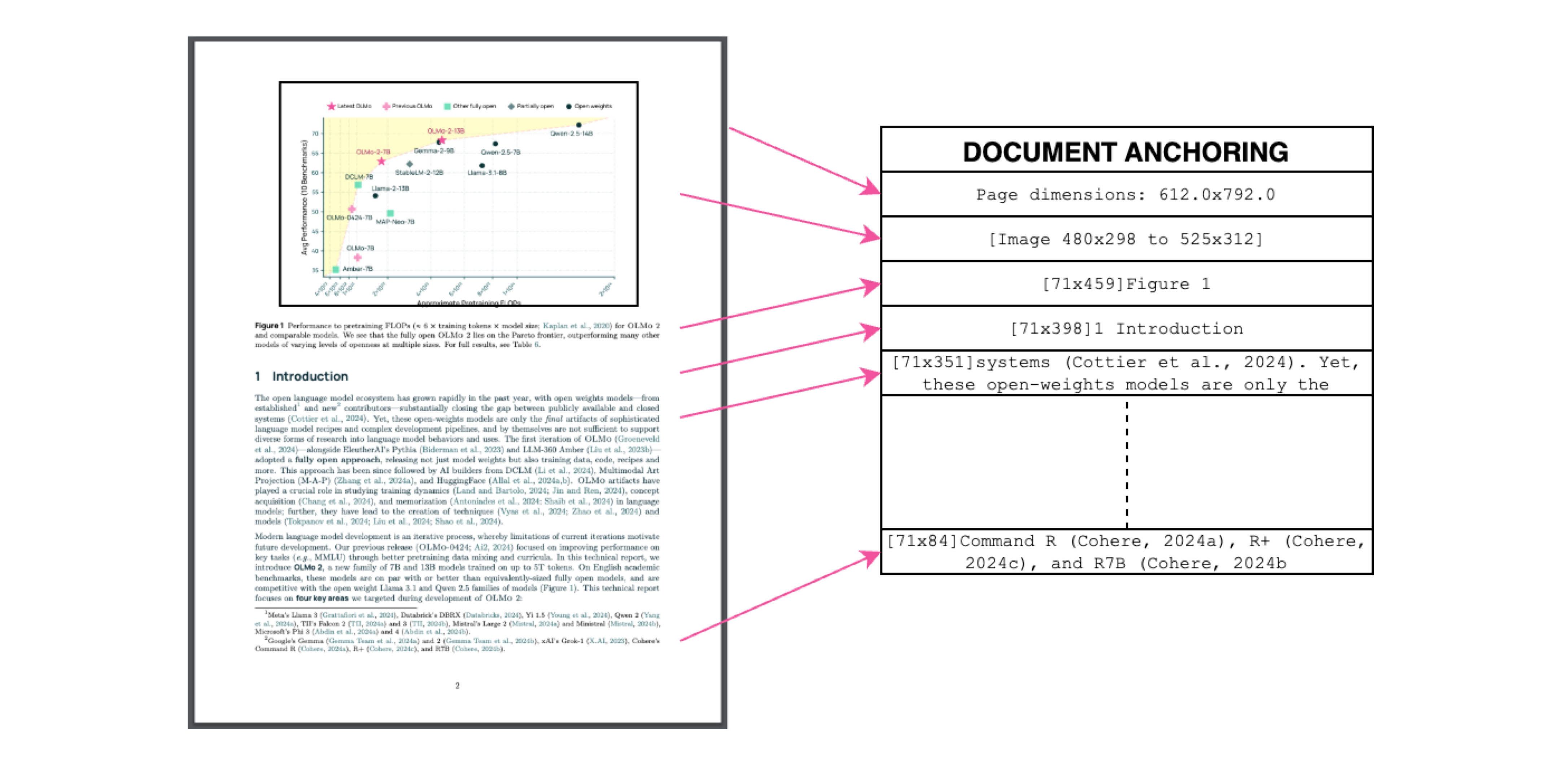

Dokumentenverankerung: Die Geheimzutat

Bildunterschrift: Text + Bildkontext = genaue Extraktion.

Bildunterschrift: Text + Bildkontext = genaue Extraktion.

Wir verwenden den eigenen Text/die Metadaten von PDFs, um VLMs während des Trainings zu "verankern":

- Extrahieren Sie Textblöcke und Bildbereiche

- Kombinieren Sie sie in Modellaufforderungen

- Lassen Sie GPT-4o "Goldstandard"-Labels generieren

Ergebnis? Ein Modell, das sowohl versteht, was Text sagt, als auch wo er hingehört.

Training für die reale Welt

- Datensatz: 60 % wissenschaftliche Arbeiten, 12 % Broschüren, 11 % juristische Dokumente

- Hardware: Optimiert für NVIDIA GPUs, 90 % geringerer Energieverbrauch als vergleichbare Setups

- Feintuning: Qwen2-VL-7B-Instruct angepasst für Dokumenten-"Konversationen"

Testen Sie olmOCR in 3 Minuten

- Installieren

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Ausführen auf einer Beispiel-PDF

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Überprüfen Sie das Markdown

Öffnen Sie

./demo_output/horribleocr.md– sehen Sie Tabellen, Gleichungen und den Textfluss intakt!

Fazit

olmOCR ist nicht nur ein weiteres Tool – es ist ein Paradigmenwechsel. Durch die Verbindung von VLMs mit transparenter Technik macht es hochwertige Textextraktion für jedermann zugänglich. Egal, ob Sie einen Forschungskorpus erstellen oder die Rechnungsverarbeitung automatisieren, dieses Toolkit gehört in Ihren Stack.

Nächste Schritte

- ⭐ Sternen Sie das GitHub-Repo

- 📊 Vergleichen Sie die Ausgaben mit dem interaktiven Tool

- 💬 Nehmen Sie an der Diskussion auf Hugging Face teil

Lassen Sie uns PDF-Ärger in Klartext-Gewinn verwandeln! 🚀