Extracción Eficiente de Texto PDF con Modelos de Lenguaje de Visión —— Por Qué olmOCR Cambia el Juego

OLMOCR Team

3 de marzo de 2025

Leyenda: El pipeline de extremo a extremo de olmOCR convierte PDFs desordenados en texto Markdown estructurado a 1/32 del costo de GPT-4o.

Leyenda: El pipeline de extremo a extremo de olmOCR convierte PDFs desordenados en texto Markdown estructurado a 1/32 del costo de GPT-4o.

El Desafío Oculto de los PDFs: Por Qué el Texto Plano Importa

Los modelos de lenguaje prosperan con texto limpio, pero los PDFs son el enemigo íntimo definitivo. Diseñados para imprimir, no para analizar, mezclan las posiciones del texto, entierran las tablas en código binario y convierten las ecuaciones en rompecabezas visuales. ¿Las herramientas OCR tradicionales? A menudo se pierden el formato, luchan con diseños de múltiples columnas o cobran una fortuna.

Ingrese olmOCR: un kit de herramientas de código abierto que combina modelos de lenguaje de visión (VLMs) con ingeniería inteligente para descifrar el código PDF. Analicemos por qué los desarrolladores e investigadores están entusiasmados con él.

5 Razones por las que olmOCR Supera a Otras Herramientas

-

Rentabilidad Difícil de Ignorar

Procese 1 millón de páginas por $190: eso es 32 veces más barato que las API por lotes de GPT-4o. ¿Cómo? Mediante el ajuste fino en 250K páginas diversas (artículos académicos, documentos legales, incluso cartas manuscritas) y la optimización de la inferencia con SGLang/vLLM.

Procese 1 millón de páginas por $190: eso es 32 veces más barato que las API por lotes de GPT-4o. ¿Cómo? Mediante el ajuste fino en 250K páginas diversas (artículos académicos, documentos legales, incluso cartas manuscritas) y la optimización de la inferencia con SGLang/vLLM. -

Magia Markdown No más pesadillas de expresiones regulares. olmOCR genera Markdown limpio con:

- Ecuaciones preservadas (

E=mc²) - Tablas que permanecen como tablas

- Orden de lectura correcto para diseños complejos

- Ecuaciones preservadas (

-

Pipeline con Baterías Incluidas

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfEscala de 1 a más de 100 GPUs sin problemas. El manejo de errores incorporado aborda los problemas comunes de los PDF, como la corrupción de metadatos.

-

Código Abierto, Cero Cajas Negras Los pesos, los datos de entrenamiento (¡sí, las 250K páginas!) y el código son públicos. Construido sobre Qwen2-VL-7B-Instruct: sin dependencias propietarias.

-

Superioridad Probada por Humanos

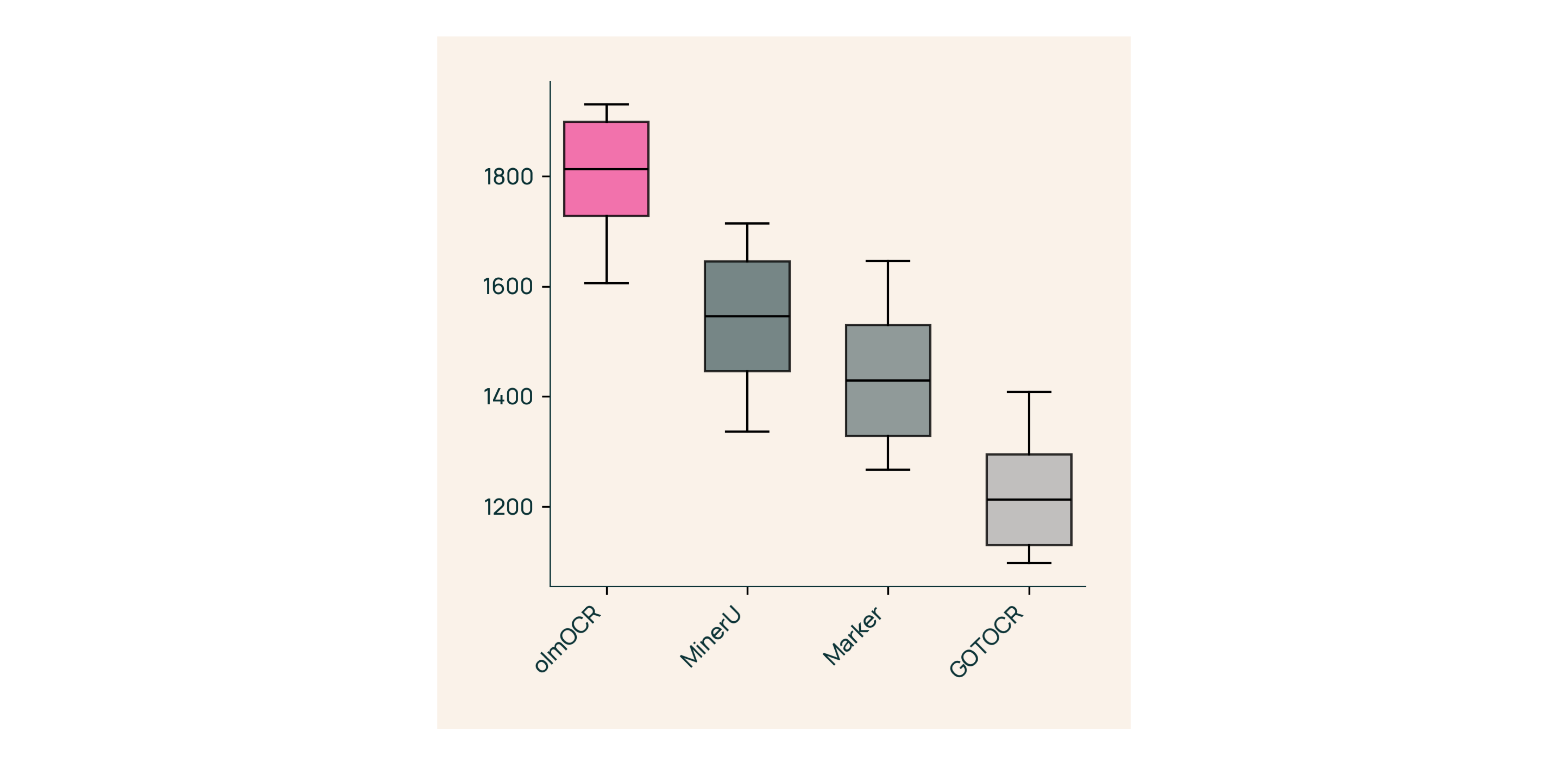

En pruebas ciegas contra Marker, GOT-OCR 2.0 y MinerU:

En pruebas ciegas contra Marker, GOT-OCR 2.0 y MinerU:- Gana el 61% de las comparaciones

- Alcanza ELO >1800 (Estándar de Oro)

Bajo el Capó: Cómo Construimos olmOCR

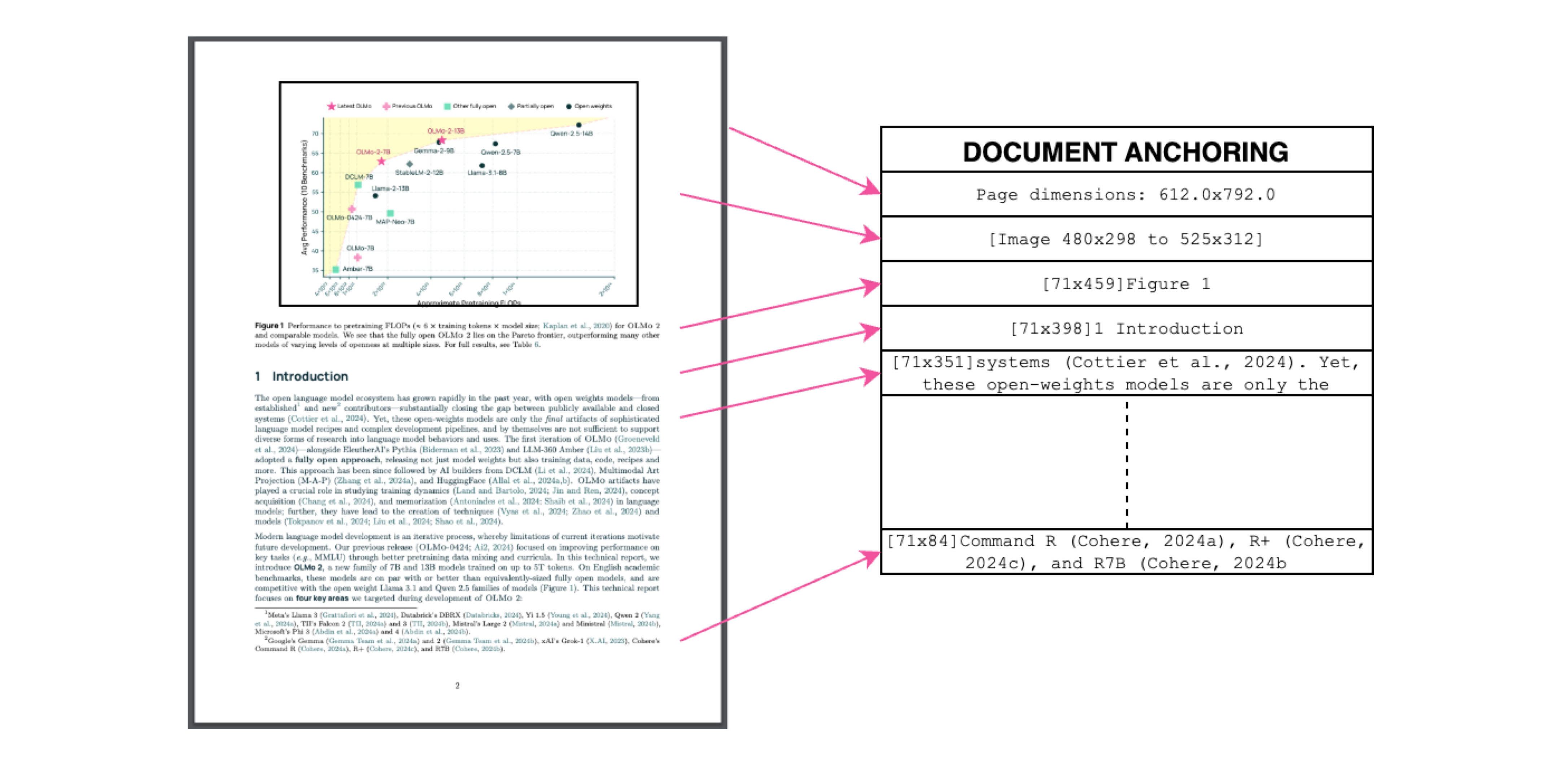

Anclaje de Documentos: El Secreto del Éxito

Leyenda: Contexto de texto + imagen = extracción precisa.

Leyenda: Contexto de texto + imagen = extracción precisa.

Usamos el propio texto/metadatos de los PDF para "anclar" los VLMs durante el entrenamiento:

- Extraer bloques de texto y regiones de imagen

- Combinarlos en indicaciones del modelo

- Dejar que GPT-4o genere etiquetas de "estándar de oro"

¿Resultado? Un modelo que entiende qué dice el texto y dónde pertenece.

Entrenamiento para el Mundo Real

- Conjunto de datos: 60% artículos académicos, 12% folletos, 11% documentos legales

- Hardware: Optimizado para GPUs NVIDIA, 90% menos uso de energía que configuraciones comparables

- Ajuste fino: Qwen2-VL-7B-Instruct adaptado para "conversaciones" de documentos

Pruebe olmOCR en 3 Minutos

- Instalar

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Ejecutar en un PDF de muestra

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Verificar el Markdown

Abra

./demo_output/horribleocr.md: ¡vea las tablas, ecuaciones y el flujo de texto intactos!

Conclusión Final

olmOCR no es solo otra herramienta, es un cambio de paradigma. Al combinar VLMs con ingeniería transparente, hace que la extracción de texto de alta calidad sea accesible para todos. Ya sea que esté construyendo un corpus de investigación o automatizando el procesamiento de facturas, este kit de herramientas pertenece a su pila.

Próximos Pasos

- ⭐ Dale una estrella al repositorio de GitHub

- 📊 Compare las salidas utilizando la Herramienta Interactiva

- 💬 Únase a la discusión en Hugging Face

¡Convirtamos el dolor de los PDF en ganancia de texto plano! 🚀