विजन लैंग्वेज मॉडल के साथ कुशल PDF टेक्स्ट निष्कर्षण —— olmOCR गेम क्यों बदलता है

OLMOCR Team

3 मार्च 2025

कैप्शन: olmOCR की एंड-टू-एंड पाइपलाइन GPT-4o की लागत के 1/32वें हिस्से पर गंदे PDFs को संरचित Markdown टेक्स्ट में बदल देती है।

कैप्शन: olmOCR की एंड-टू-एंड पाइपलाइन GPT-4o की लागत के 1/32वें हिस्से पर गंदे PDFs को संरचित Markdown टेक्स्ट में बदल देती है।

PDF का छिपा हुआ चैलेंज: सादे टेक्स्ट का महत्व

भाषा मॉडल साफ टेक्स्ट पर फलते-फूलते हैं—लेकिन PDF अंतिम दुश्मन हैं। प्रिंटिंग के लिए डिज़ाइन किए गए, पार्सिंग के लिए नहीं, वे टेक्स्ट की स्थिति को गड़बड़ कर देते हैं, बाइनरी कोड में टेबल को दफन कर देते हैं, और समीकरणों को दृश्य पहेलियों में बदल देते हैं। पारंपरिक OCR टूल? वे अक्सर स्वरूपण से चूक जाते हैं, मल्टी-कॉलम लेआउट से जूझते हैं, या भारी शुल्क लेते हैं।

olmOCR में प्रवेश करें: एक ओपन-सोर्स टूलकिट जो PDF कोड को क्रैक करने के लिए विजन-लैंग्वेज मॉडल (VLMs) को स्मार्ट इंजीनियरिंग के साथ जोड़ता है। आइए इस बात पर गौर करें कि डेवलपर्स और शोधकर्ता इसके बारे में क्यों उत्साहित हैं।

5 कारण olmOCR अन्य टूल से बेहतर है

-

लागत दक्षता जिसे अनदेखा करना मुश्किल है

1 मिलियन पृष्ठों को $190 में प्रोसेस करें—यह GPT-4o बैच APIs की तुलना में 32x सस्ता है। कैसे? 250K विविध पृष्ठों (अकादमिक पेपर, कानूनी दस्तावेज, यहां तक कि हस्तलिखित पत्र) पर फाइन-ट्यूनिंग करके और SGLang/vLLM के साथ अनुमान को अनुकूलित करके।

1 मिलियन पृष्ठों को $190 में प्रोसेस करें—यह GPT-4o बैच APIs की तुलना में 32x सस्ता है। कैसे? 250K विविध पृष्ठों (अकादमिक पेपर, कानूनी दस्तावेज, यहां तक कि हस्तलिखित पत्र) पर फाइन-ट्यूनिंग करके और SGLang/vLLM के साथ अनुमान को अनुकूलित करके। -

Markdown मैजिक अब कोई रेगुलर एक्सप्रेशन दुःस्वप्न नहीं। olmOCR साफ Markdown आउटपुट करता है जिसमें शामिल हैं:

- संरक्षित समीकरण (

E=mc²) - टेबल जो टेबल ही रहते हैं

- जटिल लेआउट के लिए सही पढ़ने का क्रम

- संरक्षित समीकरण (

-

बैटरी-इनक्लूडेड पाइपलाइन

python -m olmocr.pipeline ./workspace --pdfs your_file.pdf1 से 100+ GPUs तक निर्बाध रूप से स्केल करें। अंतर्निहित त्रुटि प्रबंधन सामान्य PDF समस्याओं जैसे मेटाडेटा भ्रष्टाचार से निपटता है।

-

ओपन सोर्स, जीरो ब्लैक बॉक्स वज़न, प्रशिक्षण डेटा (हाँ, सभी 250K पृष्ठ!), और कोड सार्वजनिक हैं। Qwen2-VL-7B-Instruct पर बनाया गया—कोई मालिकाना निर्भरता नहीं।

-

मानव-सिद्ध श्रेष्ठता

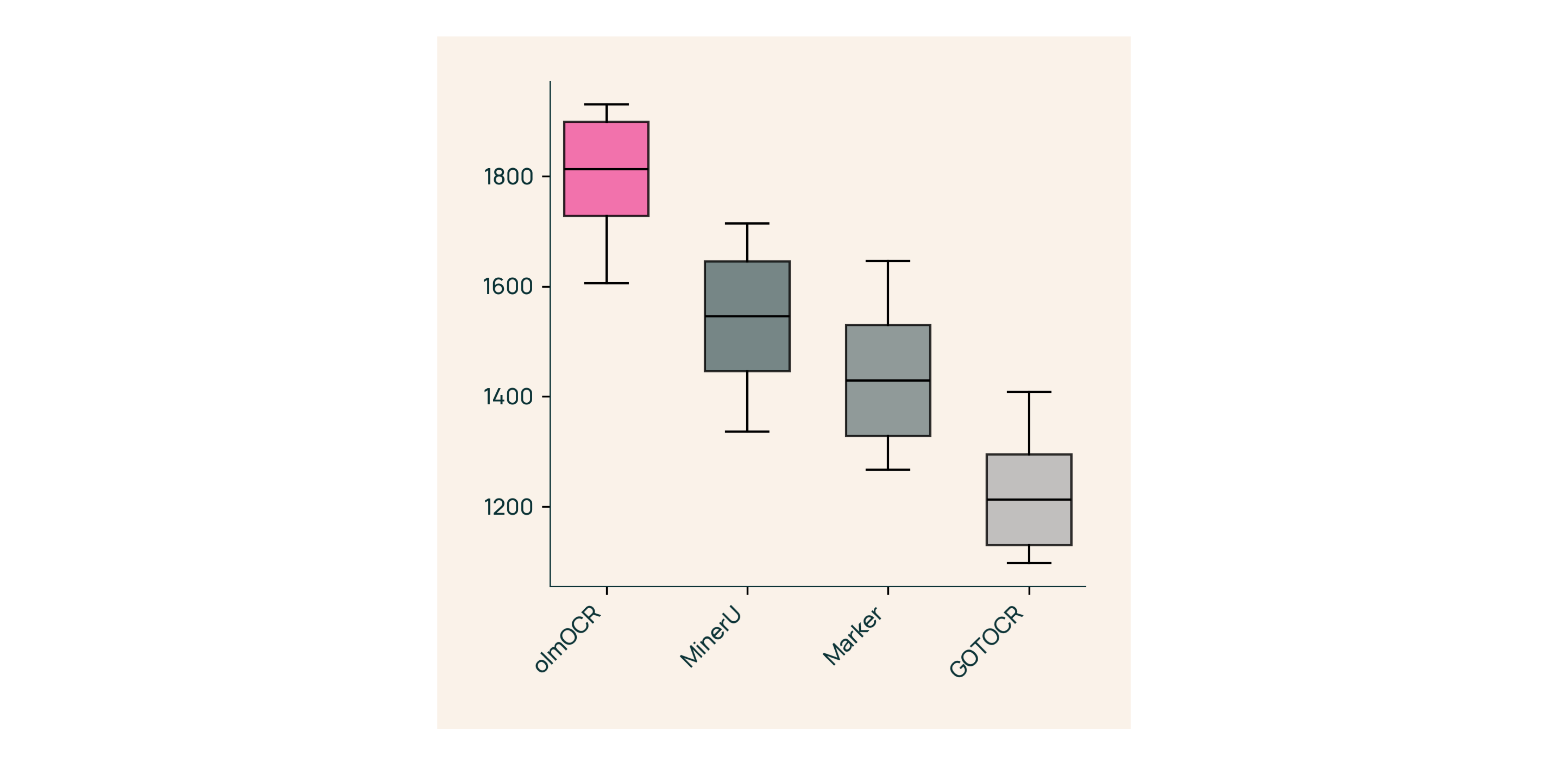

मार्कर, GOT-OCR 2.0, और MinerU के खिलाफ ब्लाइंड टेस्ट में:

मार्कर, GOT-OCR 2.0, और MinerU के खिलाफ ब्लाइंड टेस्ट में:- तुलनाओं में 61% जीतता है

- ELO >1800 (गोल्ड स्टैंडर्ड) प्राप्त करता है

हुड के नीचे: हमने olmOCR कैसे बनाया

दस्तावेज़ एंकरिंग: गुप्त सॉस

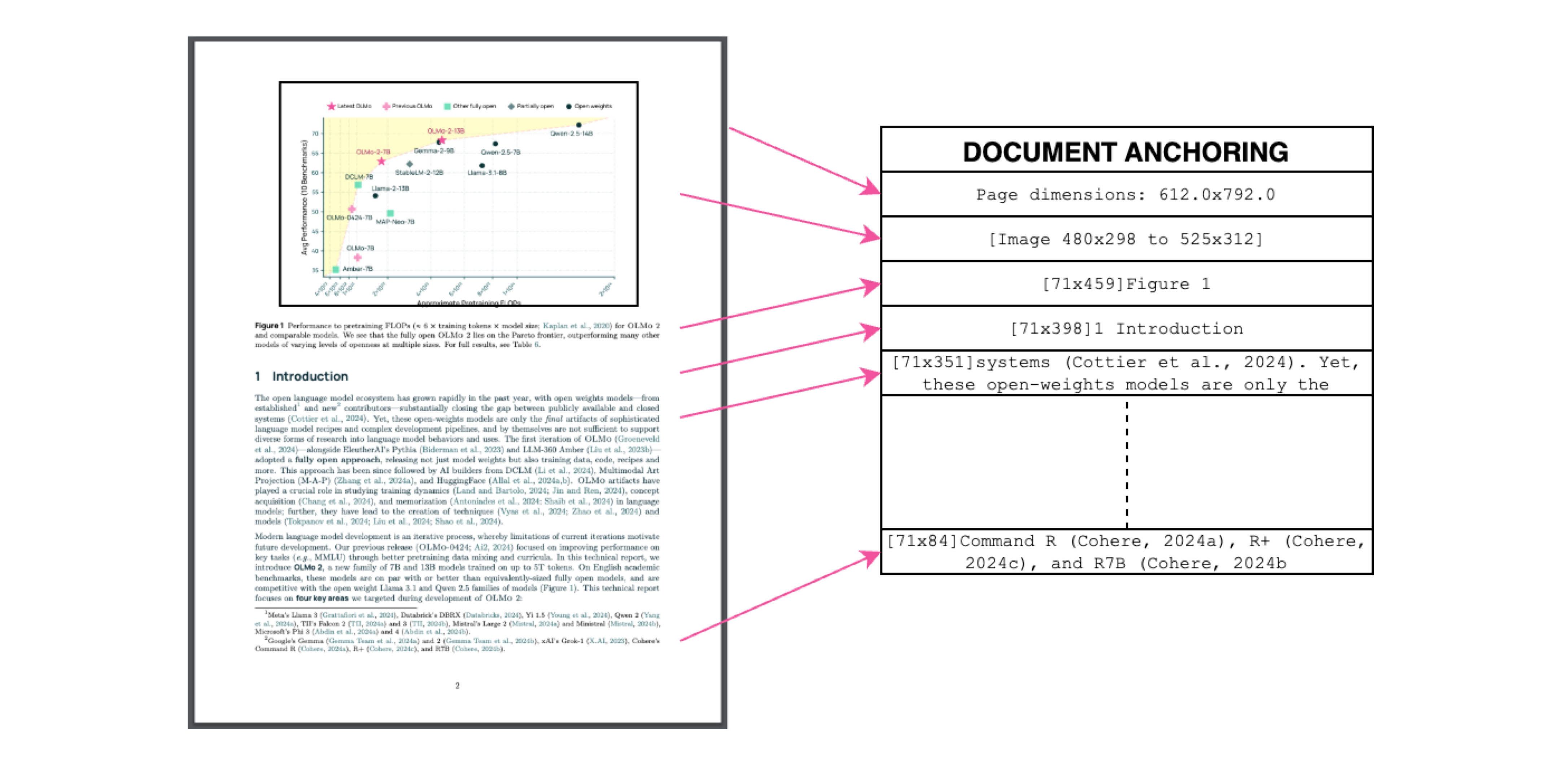

कैप्शन: टेक्स्ट + छवि संदर्भ = सटीक निष्कर्षण।

कैप्शन: टेक्स्ट + छवि संदर्भ = सटीक निष्कर्षण।

हम प्रशिक्षण के दौरान VLMs को "एंकर" करने के लिए PDFs के अपने टेक्स्ट/मेटाडेटा का उपयोग करते हैं:

- टेक्स्ट ब्लॉक और छवि क्षेत्रों को निकालें

- उन्हें मॉडल प्रॉम्प्ट में मिलाएं

- GPT-4o को "गोल्ड स्टैंडर्ड" लेबल उत्पन्न करने दें

परिणाम? एक मॉडल जो समझता है कि टेक्स्ट क्या कहता है और वह कहां है।

वास्तविक दुनिया के लिए प्रशिक्षण

- डेटासेट: 60% अकादमिक पेपर, 12% ब्रोशर, 11% कानूनी दस्तावेज

- हार्डवेयर: NVIDIA GPUs के लिए अनुकूलित, तुलनीय सेटअप की तुलना में 90% कम ऊर्जा उपयोग

- फाइन-ट्यूनिंग: दस्तावेज़ "बातचीत" के लिए Qwen2-VL-7B-Instruct को अनुकूलित किया गया

3 मिनट में olmOCR आज़माएँ

- इंस्टॉल करें

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - नमूना PDF पर चलाएँ

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Markdown की जाँच करें

./demo_output/horribleocr.mdखोलें—टेबल, समीकरण और टेक्स्ट प्रवाह को बरकरार देखें!

अंतिम निष्कर्ष

olmOCR सिर्फ एक और टूल नहीं है—यह एक प्रतिमान बदलाव है। VLMs को पारदर्शी इंजीनियरिंग के साथ जोड़कर, यह सभी के लिए उच्च-गुणवत्ता वाले टेक्स्ट निष्कर्षण को सुलभ बनाता है। चाहे आप एक शोध कॉर्पस बना रहे हों या चालान प्रसंस्करण को स्वचालित कर रहे हों, यह टूलकिट आपके स्टैक में होना चाहिए।

अगले कदम

- ⭐ GitHub रिपो को स्टार दें

- 📊 इंटरैक्टिव टूल का उपयोग करके आउटपुट की तुलना करें

- 💬 हगिंग फेस पर चर्चा में शामिल हों

आइए PDF दर्द को सादे टेक्स्ट लाभ में बदलें! 🚀