Ekstraksi Teks PDF yang Efisien dengan Model Bahasa Visi —— Mengapa olmOCR Mengubah Permainan

OLMOCR Team

3 Maret 2025

Keterangan: Alur end-to-end olmOCR mengubah PDF yang berantakan menjadi teks Markdown terstruktur dengan biaya 1/32 dari GPT-4o.

Keterangan: Alur end-to-end olmOCR mengubah PDF yang berantakan menjadi teks Markdown terstruktur dengan biaya 1/32 dari GPT-4o.

Tantangan Tersembunyi PDF: Mengapa Teks Biasa Penting

Model bahasa berkembang pesat pada teks yang bersih—tetapi PDF adalah musuh bebuyutan. Dirancang untuk pencetakan, bukan penguraian, mereka mengacaukan posisi teks, mengubur tabel dalam kode biner, dan mengubah persamaan menjadi teka-teki visual. Alat OCR tradisional? Mereka sering melewatkan pemformatan, kesulitan dengan tata letak multi-kolom, atau membebankan biaya yang mahal.

Masuklah olmOCR: sebuah toolkit sumber terbuka yang menggabungkan model bahasa visi (VLM) dengan rekayasa cerdas untuk memecahkan kode PDF. Mari kita uraikan mengapa pengembang dan peneliti bersemangat tentang hal itu.

5 Alasan olmOCR Mengungguli Alat Lain

-

Efisiensi Biaya yang Sulit Diabaikan

Proses 1 juta halaman seharga $190—itu 32x lebih murah daripada API batch GPT-4o. Bagaimana caranya? Dengan fine-tuning pada 250K halaman yang beragam (makalah akademis, dokumen hukum, bahkan surat tulisan tangan) dan mengoptimalkan inferensi dengan SGLang/vLLM.

Proses 1 juta halaman seharga $190—itu 32x lebih murah daripada API batch GPT-4o. Bagaimana caranya? Dengan fine-tuning pada 250K halaman yang beragam (makalah akademis, dokumen hukum, bahkan surat tulisan tangan) dan mengoptimalkan inferensi dengan SGLang/vLLM. -

Keajaiban Markdown Tidak ada lagi mimpi buruk regex. olmOCR menghasilkan Markdown bersih dengan:

- Persamaan yang dipertahankan (

E=mc²) - Tabel yang tetap menjadi tabel

- Urutan bacaan yang benar untuk tata letak yang kompleks

- Persamaan yang dipertahankan (

-

Alur yang Sudah Termasuk Baterai

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfSkala dari 1 hingga 100+ GPU dengan mulus. Penanganan kesalahan bawaan mengatasi masalah PDF umum seperti kerusakan metadata.

-

Sumber Terbuka, Nol Kotak Hitam Bobot, data pelatihan (ya, semua 250K halaman!), dan kode bersifat publik. Dibangun di atas Qwen2-VL-7B-Instruct—tidak ada ketergantungan kepemilikan.

-

Superioritas yang Terbukti oleh Manusia

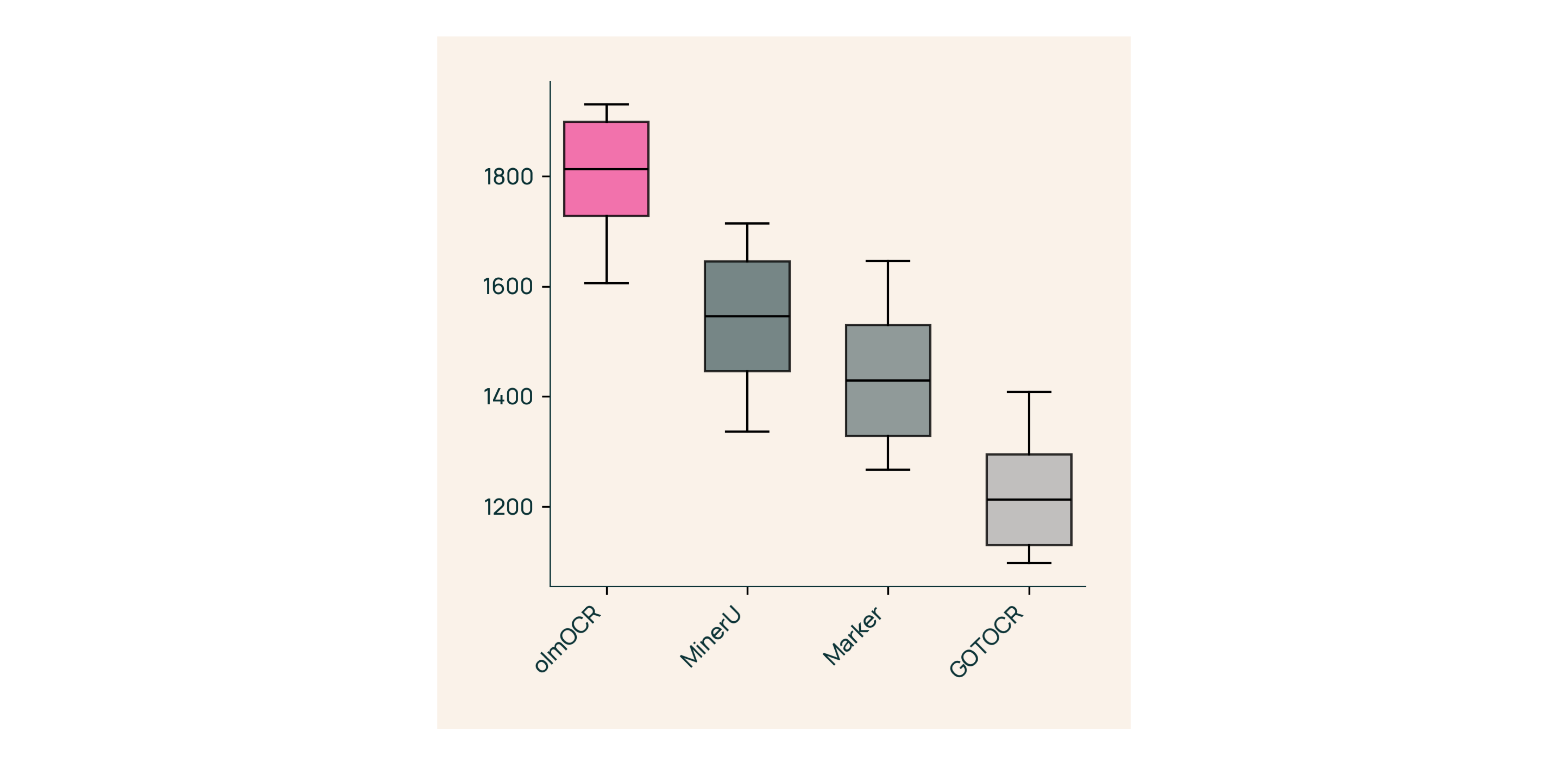

Dalam pengujian buta terhadap Marker, GOT-OCR 2.0, dan MinerU:

Dalam pengujian buta terhadap Marker, GOT-OCR 2.0, dan MinerU:- Memenangkan 61% dari perbandingan

- Mencapai ELO >1800 (Standar Emas)

Di Balik Layar: Bagaimana Kami Membangun olmOCR

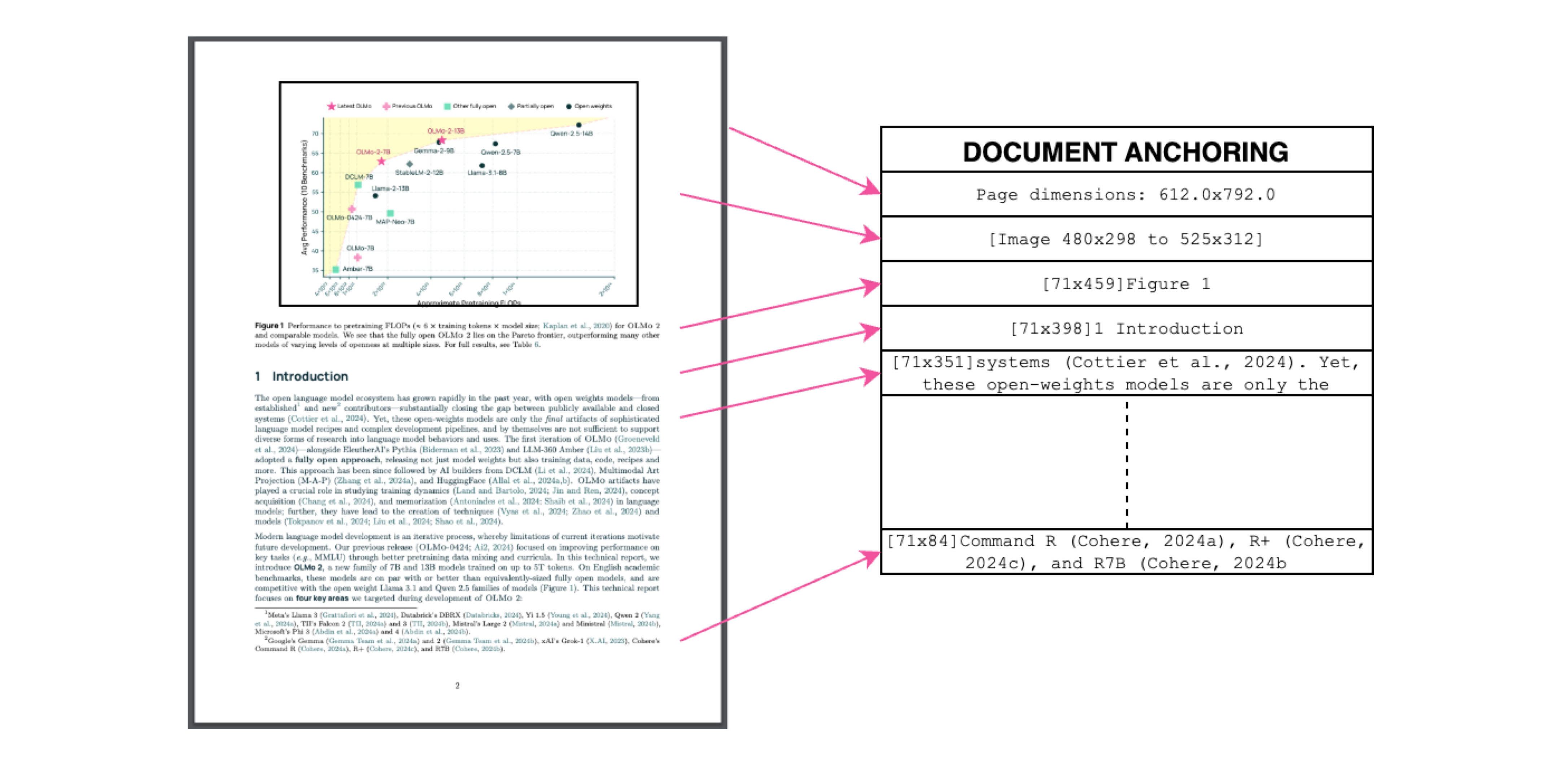

Penjangkaran Dokumen: Rahasia Sukses

Keterangan: Konteks teks + gambar = ekstraksi yang akurat.

Keterangan: Konteks teks + gambar = ekstraksi yang akurat.

Kami menggunakan teks/metadata PDF sendiri untuk "menjangkarkan" VLM selama pelatihan:

- Ekstrak blok teks & wilayah gambar

- Gabungkan mereka dalam perintah model

- Biarkan GPT-4o menghasilkan label "standar emas"

Hasilnya? Model yang memahami apa yang dikatakan teks dan di mana ia berada.

Pelatihan untuk Dunia Nyata

- Dataset: 60% makalah akademis, 12% brosur, 11% dokumen hukum

- Perangkat Keras: Dioptimalkan untuk GPU NVIDIA, penggunaan energi 90% lebih rendah daripada pengaturan serupa

- Fine-Tuning: Qwen2-VL-7B-Instruct diadaptasi untuk "percakapan" dokumen

Coba olmOCR dalam 3 Menit

- Instal

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Jalankan pada PDF Contoh

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Periksa Markdown

Buka

./demo_output/horribleocr.md—lihat tabel, persamaan, dan aliran teks tetap utuh!

Kesimpulan Akhir

olmOCR bukan hanya alat lain—ini adalah perubahan paradigma. Dengan menggabungkan VLM dengan rekayasa transparan, ia membuat ekstraksi teks berkualitas tinggi dapat diakses oleh semua orang. Apakah Anda sedang membangun korpus penelitian atau mengotomatiskan pemrosesan faktur, toolkit ini harus ada di tumpukan Anda.

Langkah Berikutnya

- ⭐ Bintang repositori GitHub

- 📊 Bandingkan keluaran menggunakan Alat Interaktif

- 💬 Bergabunglah dalam diskusi di Hugging Face

Mari ubah kesulitan PDF menjadi keuntungan teks biasa! 🚀