Efficiënte PDF-tekstextractie met Vision Language Models —— Waarom olmOCR de game verandert

OLMOCR Team

3 maart 2025

Bijschrift: olmOCR's end-to-end pipeline zet rommelige PDF's om in gestructureerde Markdown-tekst voor 1/32e van de kosten van GPT-4o.

Bijschrift: olmOCR's end-to-end pipeline zet rommelige PDF's om in gestructureerde Markdown-tekst voor 1/32e van de kosten van GPT-4o.

De verborgen uitdaging van PDF's: Waarom platte tekst ertoe doet

Taalmodellen gedijen op schone tekst, maar PDF's zijn de ultieme vijand. Ontworpen om af te drukken, niet om te parsen, ze verwarren tekstposities, begraven tabellen in binaire code en veranderen vergelijkingen in visuele puzzels. Traditionele OCR-tools? Ze missen vaak opmaak, worstelen met lay-outs met meerdere kolommen of vragen een fortuin.

Maak kennis met olmOCR: een open-source toolkit die vision-language models (VLM's) combineert met slimme engineering om de PDF-code te kraken. Laten we uiteenzetten waarom ontwikkelaars en onderzoekers er zo enthousiast over zijn.

5 redenen waarom olmOCR andere tools overtreft

-

Kostenefficiëntie die moeilijk te negeren is

Verwerk 1 miljoen pagina's voor $190 - dat is 32x goedkoper dan GPT-4o batch-API's. Hoe? Door fine-tuning op 250K diverse pagina's (academische papers, juridische documenten, zelfs handgeschreven brieven) en het optimaliseren van de inferentie met SGLang/vLLM.

Verwerk 1 miljoen pagina's voor $190 - dat is 32x goedkoper dan GPT-4o batch-API's. Hoe? Door fine-tuning op 250K diverse pagina's (academische papers, juridische documenten, zelfs handgeschreven brieven) en het optimaliseren van de inferentie met SGLang/vLLM. -

Markdown-magie Geen regex-nachtmerries meer. olmOCR produceert schone Markdown met:

- Behouden vergelijkingen (

E=mc²) - Tabellen die tabellen blijven

- Correcte leesvolgorde voor complexe lay-outs

- Behouden vergelijkingen (

-

Batterijen-inbegrepen pipeline

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfSchaal naadloos van 1 tot 100+ GPU's. Ingebouwde foutafhandeling pakt veelvoorkomende PDF-problemen aan, zoals metadata-corruptie.

-

Open source, nul black boxes Gewichten, trainingsdata (ja, alle 250K pagina's!) en code zijn openbaar. Gebouwd op Qwen2-VL-7B-Instruct - geen eigen afhankelijkheden.

-

Door mensen bewezen superioriteit

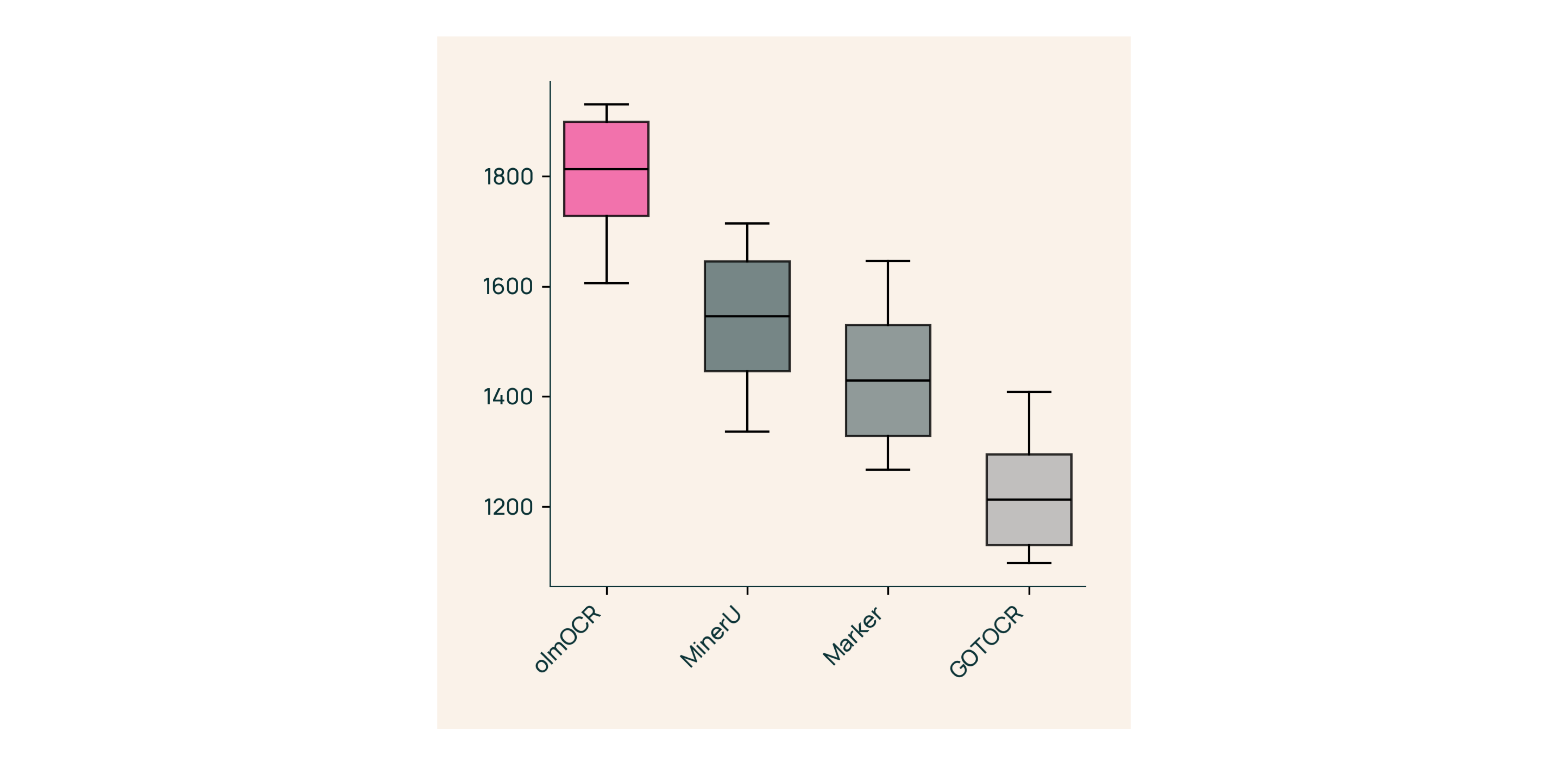

In blinde tests tegen Marker, GOT-OCR 2.0 en MinerU:

In blinde tests tegen Marker, GOT-OCR 2.0 en MinerU:- Wint 61% van de vergelijkingen

- Behaalt ELO >1800 (Gouden Standaard)

Onder de motorkap: Hoe we olmOCR hebben gebouwd

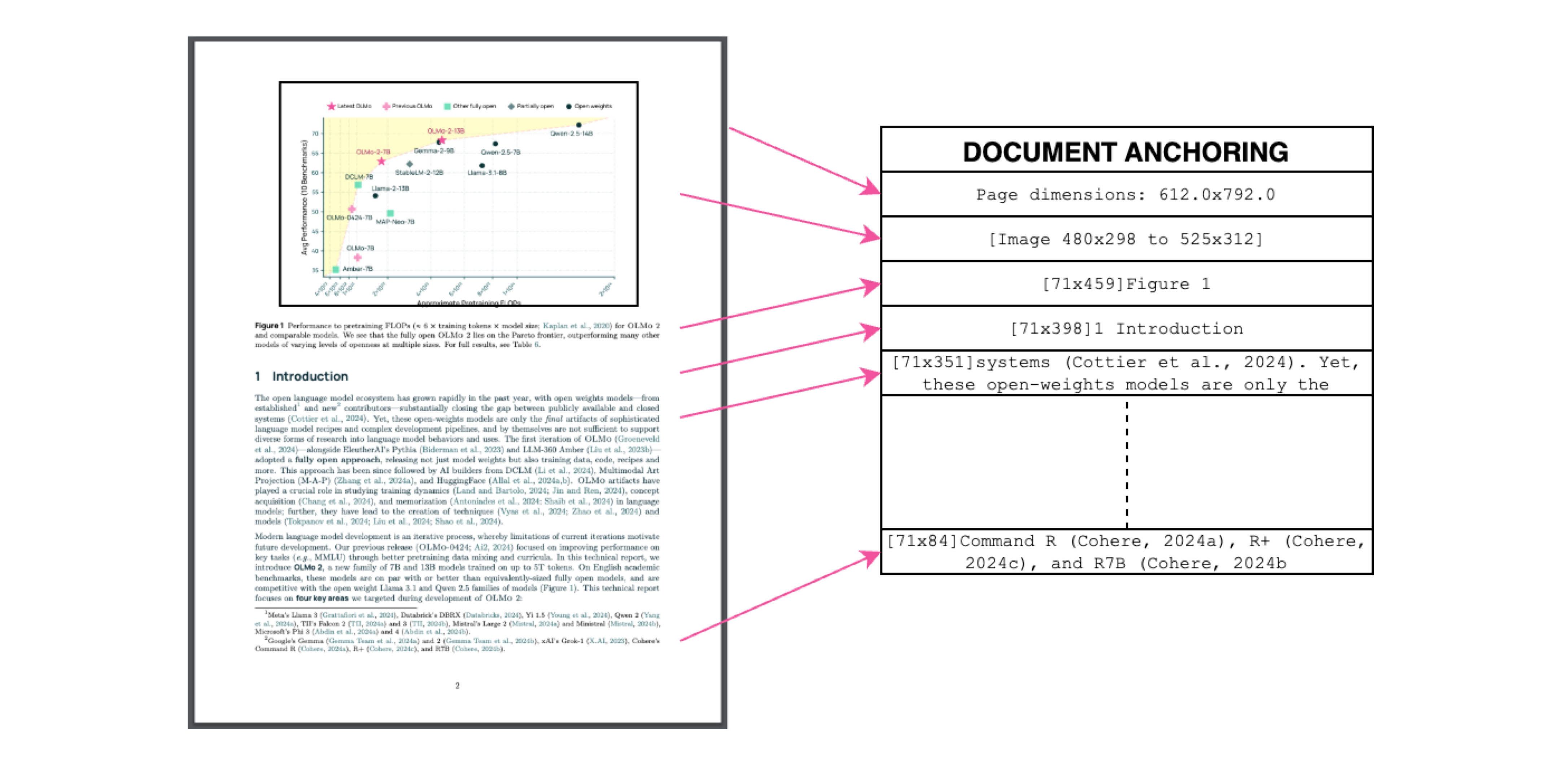

Documentverankering: De geheime saus

Bijschrift: Tekst + beeldcontext = nauwkeurige extractie.

Bijschrift: Tekst + beeldcontext = nauwkeurige extractie.

We gebruiken de eigen tekst/metadata van PDF's om VLM's te "verankeren" tijdens de training:

- Extraheer tekstblokken en beelddelen

- Combineer ze in modelprompts

- Laat GPT-4o "gouden standaard" labels genereren

Resultaat? Een model dat begrijpt wat tekst zegt en waar deze thuishoort.

Trainen voor de echte wereld

- Dataset: 60% academische papers, 12% brochures, 11% juridische documenten

- Hardware: Geoptimaliseerd voor NVIDIA GPU's, 90% lager energieverbruik dan vergelijkbare setups

- Fine-tuning: Qwen2-VL-7B-Instruct aangepast voor document "gesprekken"

Probeer olmOCR in 3 minuten

- Installeer

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Voer uit op een voorbeeld-PDF

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Controleer de Markdown

Open

./demo_output/horribleocr.md- zie tabellen, vergelijkingen en tekststroom intact!

Eindconclusie

olmOCR is niet zomaar een tool - het is een paradigmaverschuiving. Door VLM's te combineren met transparante engineering, maakt het hoogwaardige tekstextractie toegankelijk voor iedereen. Of je nu een onderzoekscorpus bouwt of factuurverwerking automatiseert, deze toolkit hoort in je stack.

Volgende stappen

- ⭐ Ster de GitHub repo

- 📊 Vergelijk uitvoer met de Interactieve Tool

- 💬 Neem deel aan de discussie op Hugging Face

Laten we PDF-pijn omzetten in platte-tekst-winst! 🚀