Extração Eficiente de Texto de PDF com Modelos de Linguagem de Visão —— Por que olmOCR Muda o Jogo

OLMOCR Team

3 de março de 2025

Legenda: O pipeline completo do olmOCR converte PDFs confusos em texto Markdown estruturado por 1/32 do custo do GPT-4o.

Legenda: O pipeline completo do olmOCR converte PDFs confusos em texto Markdown estruturado por 1/32 do custo do GPT-4o.

O Desafio Oculto dos PDFs: Por que Texto Simples Importa

Modelos de linguagem prosperam com texto limpo — mas PDFs são o inimigo-amigo definitivo. Projetados para impressão, não para análise, eles embaralham posições de texto, enterram tabelas em código binário e transformam equações em quebra-cabeças visuais. Ferramentas OCR tradicionais? Muitas vezes, perdem a formatação, lutam com layouts de várias colunas ou cobram uma fortuna.

Apresentamos o olmOCR: um kit de ferramentas de código aberto que combina modelos de linguagem de visão (VLMs) com engenharia inteligente para decifrar o código PDF. Vamos detalhar por que desenvolvedores e pesquisadores estão entusiasmados com ele.

5 Razões pelas quais olmOCR Supera Outras Ferramentas

-

Eficiência de Custos Difícil de Ignorar

Processar 1 milhão de páginas por $190 — isso é 32x mais barato do que as APIs em lote do GPT-4o. Como? Por meio de ajuste fino em 250 mil páginas diversas (artigos acadêmicos, documentos legais, até mesmo cartas manuscritas) e otimização de inferência com SGLang/vLLM.

Processar 1 milhão de páginas por $190 — isso é 32x mais barato do que as APIs em lote do GPT-4o. Como? Por meio de ajuste fino em 250 mil páginas diversas (artigos acadêmicos, documentos legais, até mesmo cartas manuscritas) e otimização de inferência com SGLang/vLLM. -

Magia Markdown Chega de pesadelos com regex. olmOCR gera Markdown limpo com:

- Equações preservadas (

E=mc²) - Tabelas que permanecem tabelas

- Ordem de leitura correta para layouts complexos

- Equações preservadas (

-

Pipeline com Tudo Incluído

python -m olmocr.pipeline ./workspace --pdfs seu_arquivo.pdfEscalabilidade de 1 a mais de 100 GPUs sem problemas. Tratamento de erros integrado lida com problemas comuns de PDF, como corrupção de metadados.

-

Código Aberto, Sem Caixas Pretas Pesos, dados de treinamento (sim, todas as 250 mil páginas!) e código são públicos. Construído com base em Qwen2-VL-7B-Instruct — sem dependências proprietárias.

-

Superioridade Comprovada por Humanos

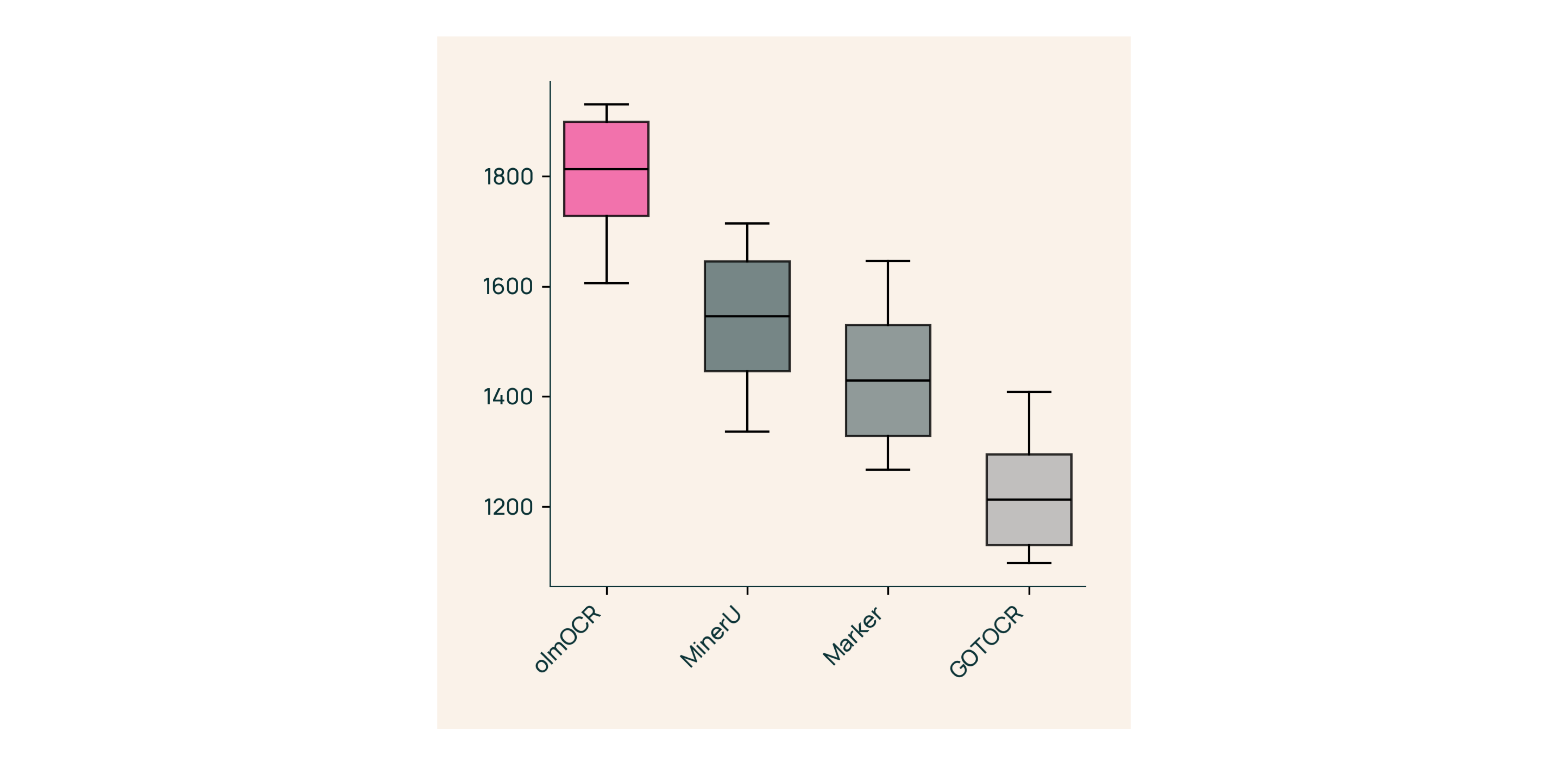

Em testes cegos contra Marker, GOT-OCR 2.0 e MinerU:

Em testes cegos contra Marker, GOT-OCR 2.0 e MinerU:- Vence 61% das comparações

- Alcança ELO >1800 (Padrão Ouro)

Sob o Capô: Como Construímos o olmOCR

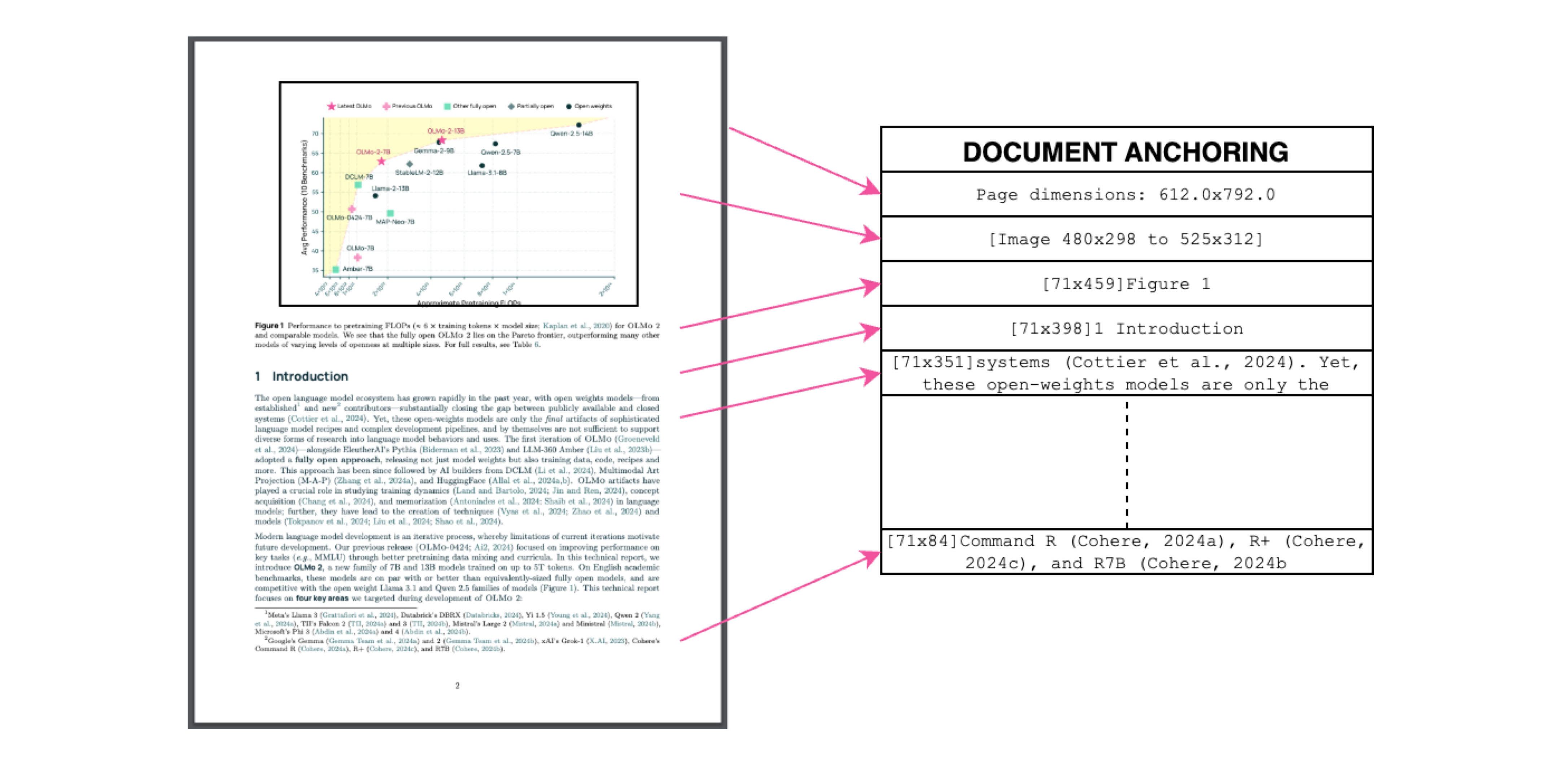

Ancoragem de Documentos: O Segredo do Sucesso

Legenda: Contexto de texto + imagem = extração precisa.

Legenda: Contexto de texto + imagem = extração precisa.

Usamos o próprio texto/metadados dos PDFs para "ancorar" VLMs durante o treinamento:

- Extrair blocos de texto e regiões de imagem

- Combiná-los em prompts de modelo

- Deixar o GPT-4o gerar rótulos de "padrão ouro"

Resultado? Um modelo que entende o que o texto diz e onde ele pertence.

Treinamento para o Mundo Real

- Conjunto de dados: 60% artigos acadêmicos, 12% brochuras, 11% documentos legais

- Hardware: Otimizado para GPUs NVIDIA, 90% menor uso de energia do que configurações comparáveis

- Ajuste fino: Qwen2-VL-7B-Instruct adaptado para "conversas" de documentos

Experimente o olmOCR em 3 Minutos

- Instale

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Execute em um PDF de exemplo

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Verifique o Markdown

Abra

./demo_output/horribleocr.md— veja tabelas, equações e fluxo de texto intactos!

Considerações Finais

olmOCR não é apenas mais uma ferramenta — é uma mudança de paradigma. Ao combinar VLMs com engenharia transparente, ele torna a extração de texto de alta qualidade acessível a todos. Seja você construindo um corpus de pesquisa ou automatizando o processamento de faturas, este kit de ferramentas pertence à sua pilha.

Próximos Passos

- ⭐ Dê uma estrela ao repositório do GitHub

- 📊 Compare as saídas usando a Ferramenta Interativa

- 💬 Participe da discussão no Hugging Face

Vamos transformar a dor dos PDFs em ganho de texto simples! 🚀