Эффективное извлечение текста из PDF с помощью моделей "зрение-язык" —— почему olmOCR меняет правила игры

OLMOCR Team

3 марта 2025 г.

Подпись: Сквозной конвейер olmOCR преобразует сложные PDF-файлы в структурированный текст Markdown по цене в 1/32 от GPT-4o.

Подпись: Сквозной конвейер olmOCR преобразует сложные PDF-файлы в структурированный текст Markdown по цене в 1/32 от GPT-4o.

Скрытая проблема PDF: почему простой текст важен

Языковые модели процветают на чистом тексте, но PDF-файлы — это их главный враг. Разработанные для печати, а не для синтаксического анализа, они искажают положение текста, прячут таблицы в двоичном коде и превращают уравнения в визуальные головоломки. Традиционные инструменты OCR? Они часто пропускают форматирование, плохо справляются с многоколоночными макетами или стоят целое состояние.

Представляем olmOCR: инструментарий с открытым исходным кодом, который сочетает в себе модели "зрение-язык" (VLMs) с интеллектуальной инженерией для взлома кода PDF. Давайте разберемся, почему разработчики и исследователи так взволнованы этим.

5 причин, по которым olmOCR превосходит другие инструменты

-

Экономичность, которую трудно игнорировать

Обработайте 1 миллион страниц за 190 долларов — это в 32 раза дешевле, чем пакетные API GPT-4o. Как? Путем точной настройки на 250 тыс. различных страниц (научные статьи, юридические документы и даже рукописные письма) и оптимизации вывода с помощью SGLang/vLLM.

Обработайте 1 миллион страниц за 190 долларов — это в 32 раза дешевле, чем пакетные API GPT-4o. Как? Путем точной настройки на 250 тыс. различных страниц (научные статьи, юридические документы и даже рукописные письма) и оптимизации вывода с помощью SGLang/vLLM. -

Магия Markdown Больше никаких кошмаров с регулярными выражениями. olmOCR выводит чистый Markdown с:

- Сохраненными уравнениями (

E=mc²) - Таблицами, которые остаются таблицами

- Правильным порядком чтения для сложных макетов

- Сохраненными уравнениями (

-

Готовый конвейер

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfМасштабируйте от 1 до 100+ графических процессоров без проблем. Встроенная обработка ошибок устраняет распространенные проблемы PDF, такие как повреждение метаданных.

-

Открытый исходный код, никаких черных ящиков Веса, обучающие данные (да, все 250 тыс. страниц!) и код являются общедоступными. Создано на основе Qwen2-VL-7B-Instruct — никаких проприетарных зависимостей.

-

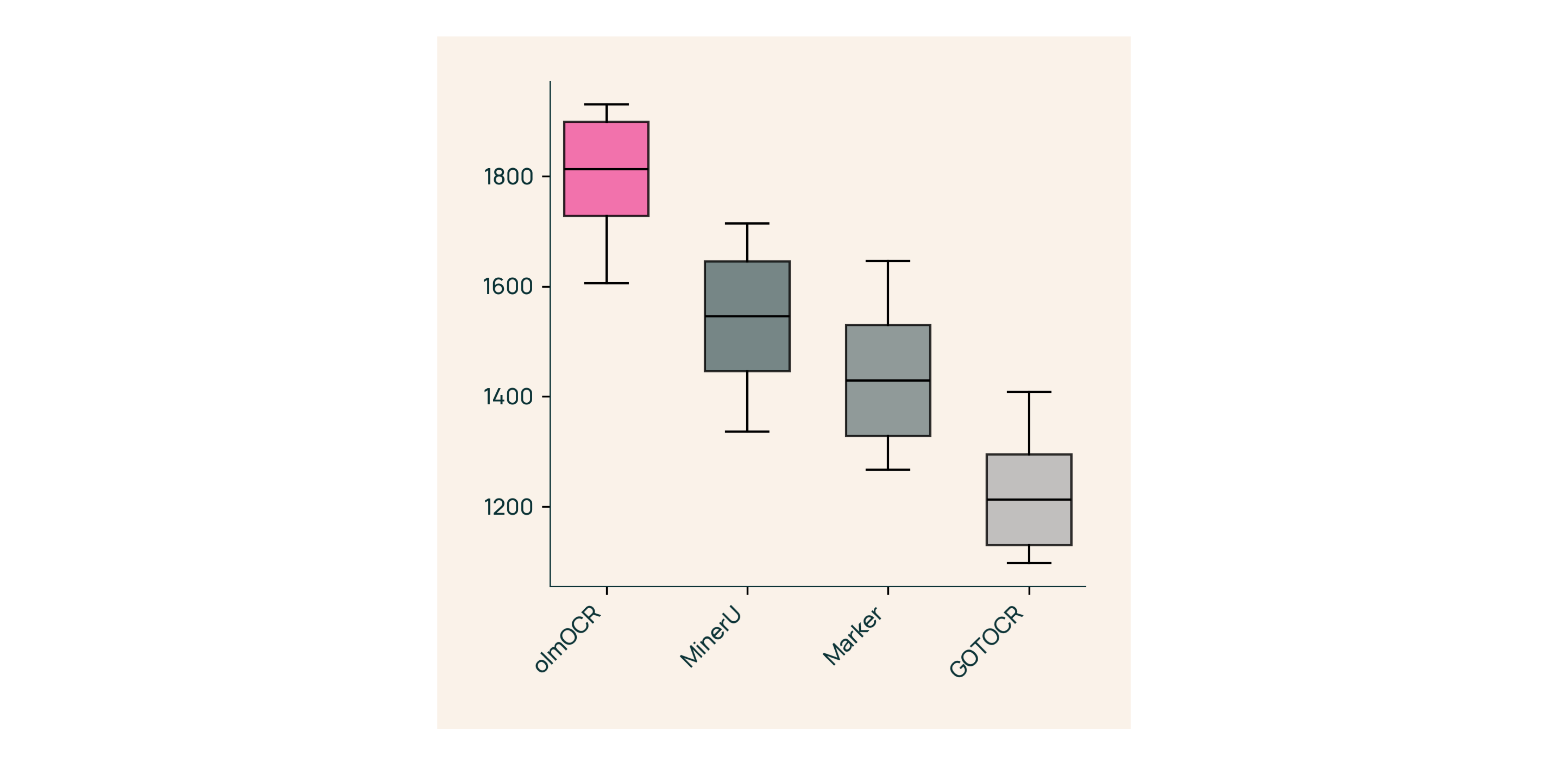

Превосходство, доказанное людьми

В слепых тестах против Marker, GOT-OCR 2.0 и MinerU:

В слепых тестах против Marker, GOT-OCR 2.0 и MinerU:- Выигрывает 61% сравнений

- Достигает ELO >1800 (золотой стандарт)

Под капотом: как мы создали olmOCR

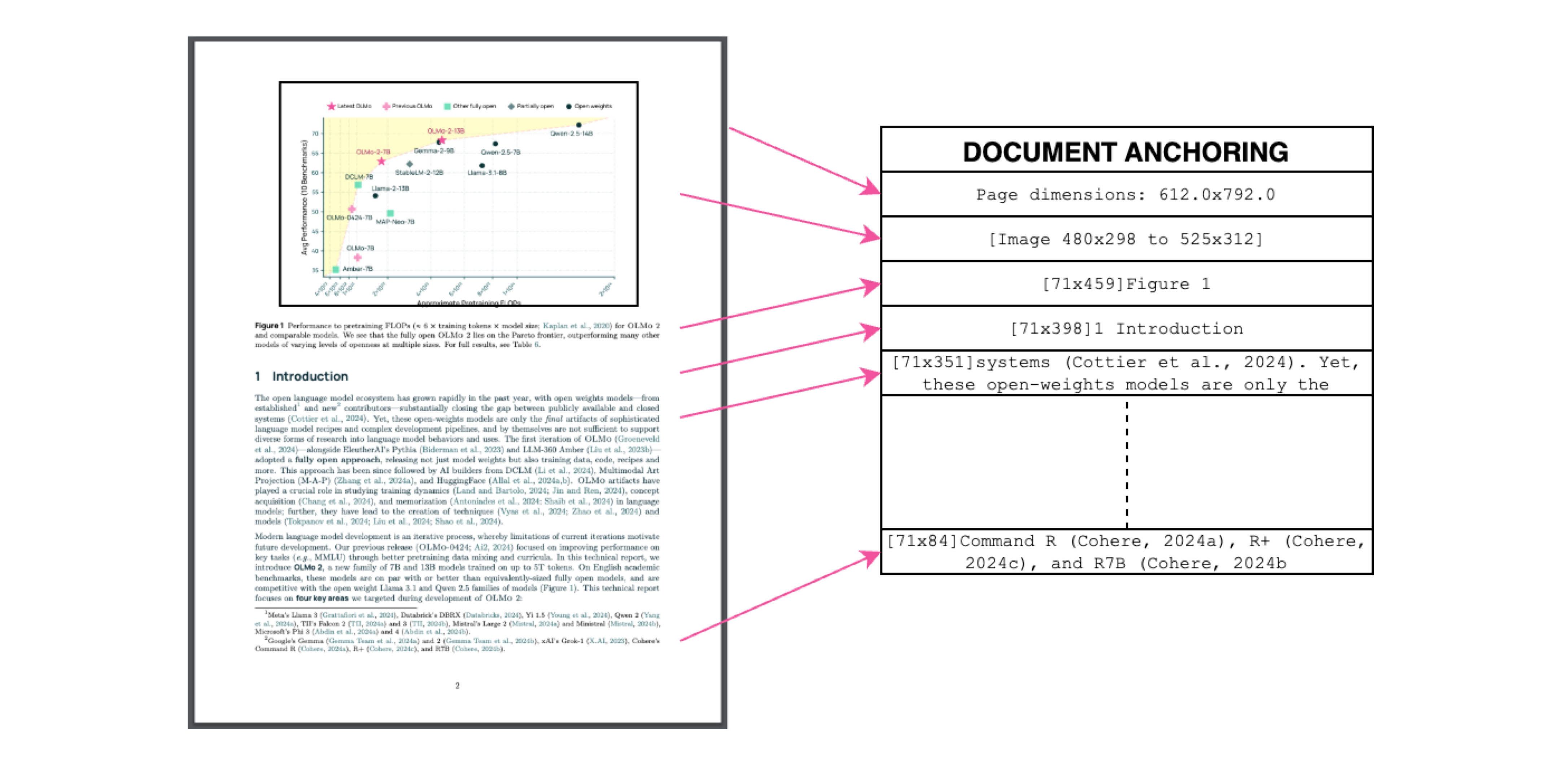

Привязка документа: секретный ингредиент

Подпись: Текст + контекст изображения = точное извлечение.

Подпись: Текст + контекст изображения = точное извлечение.

Мы используем собственный текст/метаданные PDF для "привязки" VLMs во время обучения:

- Извлечение текстовых блоков и областей изображений

- Объединение их в подсказки модели

- Позволить GPT-4o генерировать "золотой стандарт" меток

Результат? Модель, которая понимает как что говорит текст, так и где он должен быть.

Обучение для реального мира

- Набор данных: 60% научные статьи, 12% брошюры, 11% юридические документы

- Оборудование: Оптимизировано для графических процессоров NVIDIA, потребление энергии на 90% ниже, чем у сопоставимых настроек

- Тонкая настройка: Qwen2-VL-7B-Instruct адаптирован для "бесед" с документами

Попробуйте olmOCR за 3 минуты

- Установите

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Запустите на примере PDF

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Проверьте Markdown

Откройте

./demo_output/horribleocr.md— увидите таблицы, уравнения и неповрежденный поток текста!

Заключение

olmOCR — это не просто еще один инструмент, это смена парадигмы. Сочетая VLMs с прозрачной инженерией, он делает высококачественное извлечение текста доступным для всех. Независимо от того, создаете ли вы исследовательский корпус или автоматизируете обработку счетов, этот инструментарий должен быть в вашем стеке.

Следующие шаги

- ⭐ Поставьте звезду репозиторию GitHub

- 📊 Сравните результаты, используя интерактивный инструмент

- 💬 Присоединяйтесь к обсуждению на Hugging Face

Давайте превратим боль PDF в простое получение текста! 🚀