Effektiv PDF-textutvinning med Vision Language Models —— Varför olmOCR förändrar spelet

OLMOCR Team

3 mars 2025

Bildtext: olmOCRs end-to-end pipeline konverterar röriga PDF-filer till strukturerad Markdown-text till 1/32-dels kostnaden av GPT-4o.

Bildtext: olmOCRs end-to-end pipeline konverterar röriga PDF-filer till strukturerad Markdown-text till 1/32-dels kostnaden av GPT-4o.

Den dolda utmaningen med PDF-filer: Varför ren text är viktig

Språkmodeller trivs på ren text – men PDF-filer är den ultimata "frenemyn". Designade för utskrift, inte parsing, de blandar ihop textpositioner, begraver tabeller i binär kod och förvandlar ekvationer till visuella pussel. Traditionella OCR-verktyg? De missar ofta formatering, kämpar med flerspaltslayouter eller tar ut en förmögenhet.

Möt olmOCR: en open-source verktygslåda som kombinerar vision-language models (VLMs) med smart teknik för att knäcka PDF-koden. Låt oss bryta ner varför utvecklare och forskare är så entusiastiska över den.

5 anledningar till varför olmOCR överglänser andra verktyg

-

Kostnadseffektivitet som är svår att ignorera

Bearbeta 1 miljon sidor för $190 – det är 32x billigare än GPT-4o batch-API:er. Hur? Genom finjustering på 250 000 olika sidor (akademiska artiklar, juridiska dokument, till och med handskrivna brev) och optimering av inferens med SGLang/vLLM.

Bearbeta 1 miljon sidor för $190 – det är 32x billigare än GPT-4o batch-API:er. Hur? Genom finjustering på 250 000 olika sidor (akademiska artiklar, juridiska dokument, till och med handskrivna brev) och optimering av inferens med SGLang/vLLM. -

Markdown-magi Inga fler regex-mardrömmar. olmOCR matar ut ren Markdown med:

- Bevarade ekvationer (

E=mc²) - Tabeller som förblir tabeller

- Korrekt läsordning för komplexa layouter

- Bevarade ekvationer (

-

Batterier-inkluderad pipeline

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfSkala från 1 till 100+ GPU:er sömlöst. Inbyggd felhantering tacklar vanliga PDF-problem som metadata-korruption.

-

Open Source, inga svarta lådor Vikter, träningsdata (ja, alla 250 000 sidor!) och kod är offentliga. Byggd på Qwen2-VL-7B-Instruct – inga proprietära beroenden.

-

Mänskligt bevisad överlägsenhet

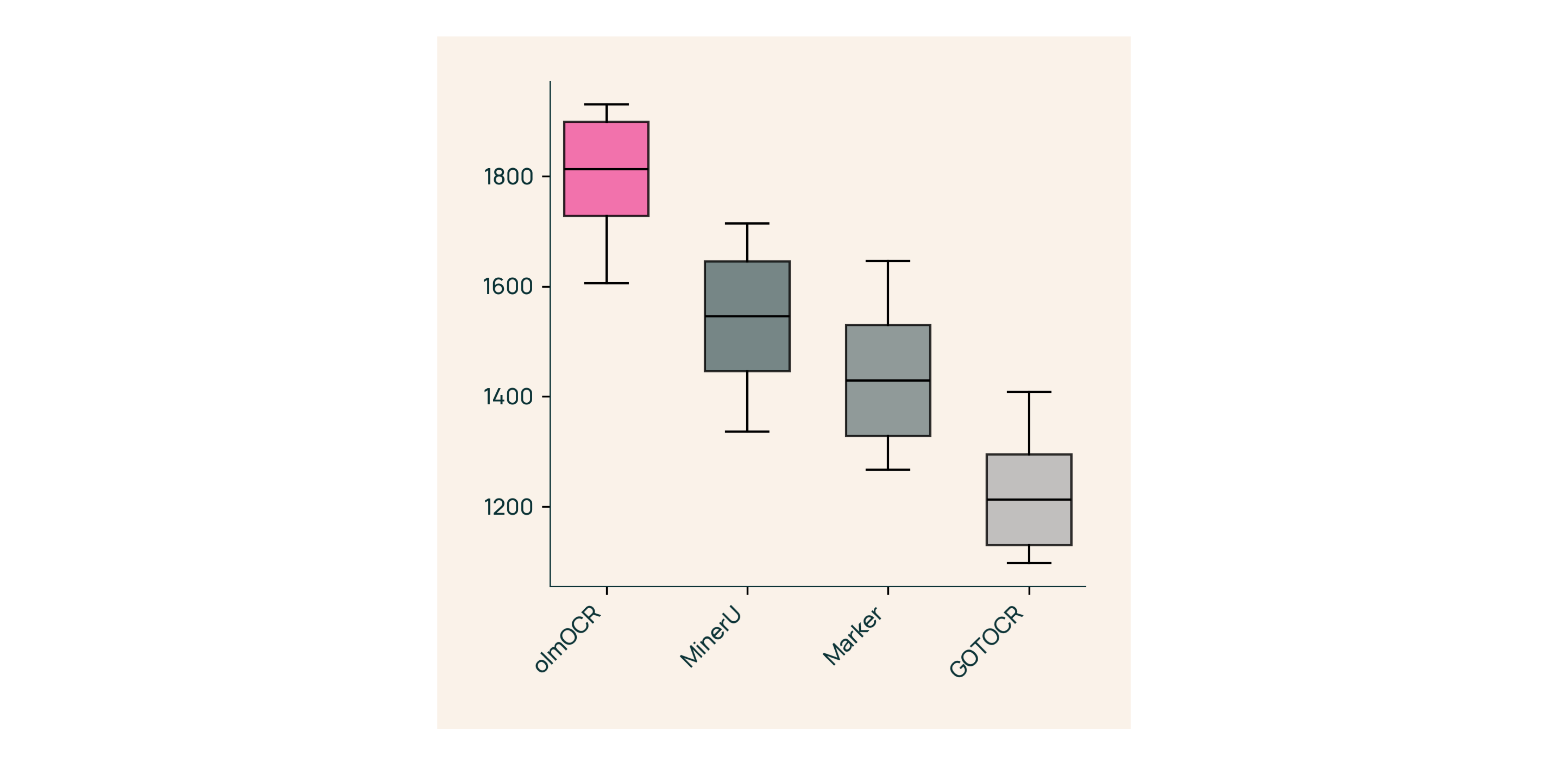

I blinda tester mot Marker, GOT-OCR 2.0 och MinerU:

I blinda tester mot Marker, GOT-OCR 2.0 och MinerU:- Vinner 61% av jämförelserna

- Uppnår ELO >1800 (Guldstandard)

Under huven: Hur vi byggde olmOCR

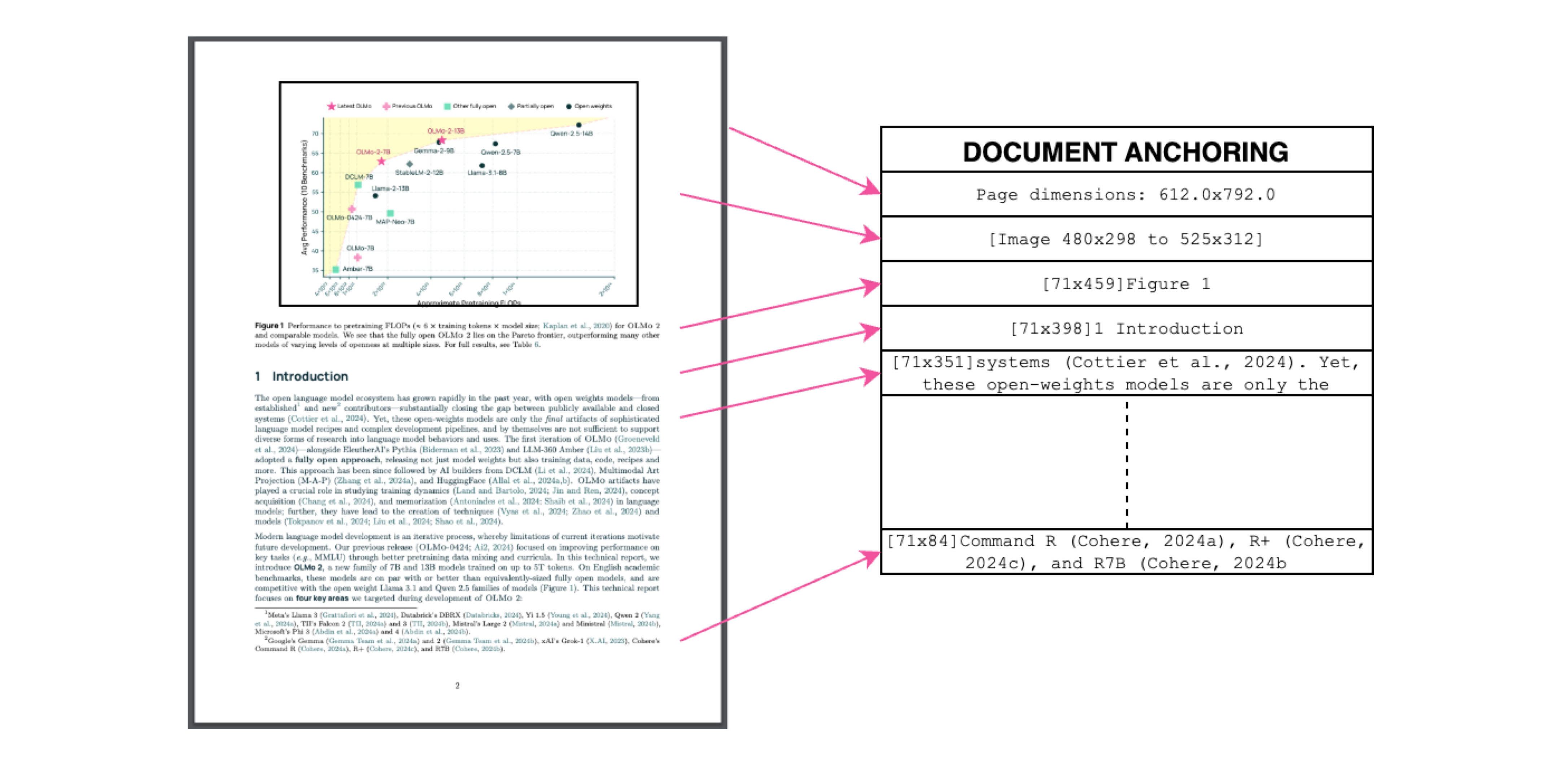

Dokumentförankring: Den hemliga ingrediensen

Bildtext: Text + bildkontext = korrekt utvinning.

Bildtext: Text + bildkontext = korrekt utvinning.

Vi använder PDF-filers egen text/metadata för att "förankra" VLMs under träning:

- Extrahera textblock och bildregioner

- Kombinera dem i modellprompter

- Låt GPT-4o generera "guldstandard"-etiketter

Resultat? En modell som förstår både vad texten säger och var den hör hemma.

Träning för den verkliga världen

- Dataset: 60% akademiska artiklar, 12% broschyrer, 11% juridiska dokument

- Hårdvara: Optimerad för NVIDIA GPU:er, 90% lägre energiförbrukning än jämförbara uppsättningar

- Finjustering: Qwen2-VL-7B-Instruct anpassad för dokument "konversationer"

Prova olmOCR på 3 minuter

- Installera

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Kör på exempel-PDF

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Kontrollera Markdown

Öppna

./demo_output/horribleocr.md– se tabeller, ekvationer och textflöde intakt!

Slutsats

olmOCR är inte bara ett verktyg – det är ett paradigmskifte. Genom att kombinera VLMs med transparent teknik gör det högkvalitativ textutvinning tillgänglig för alla. Oavsett om du bygger en forskningskorpus eller automatiserar fakturabearbetning, hör den här verktygslådan hemma i din stack.

Nästa steg

- ⭐ Stjärnmärk GitHub-repot

- 📊 Jämför utdata med Interaktivt verktyg

- 💬 Delta i diskussionen på Hugging Face

Låt oss förvandla PDF-smärta till ren textvinst! 🚀