Ефективне вилучення тексту з PDF за допомогою візуально-мовних моделей —— чому olmOCR змінює правила гри

OLMOCR Team

3 березня 2025 р.

Підпис: Наскрізний конвеєр olmOCR перетворює заплутані PDF-файли на структурований текст Markdown за ціною, що в 32 рази нижча, ніж у GPT-4o.

Підпис: Наскрізний конвеєр olmOCR перетворює заплутані PDF-файли на структурований текст Markdown за ціною, що в 32 рази нижча, ніж у GPT-4o.

Прихована проблема PDF: чому простий текст має значення

Мовні моделі процвітають на чистому тексті, але PDF-файли — це їхній головний ворог. Розроблені для друку, а не для аналізу, вони плутають розташування тексту, ховають таблиці в двійковому коді та перетворюють рівняння на візуальні головоломки. Традиційні інструменти OCR? Вони часто пропускають форматування, мають проблеми з багатоколонковими макетами або коштують цілий статок.

Представляємо olmOCR: інструментарій з відкритим кодом, який поєднує візуально-мовні моделі (VLM) з розумною інженерією, щоб зламати код PDF. Давайте розберемо, чому розробники та дослідники так захоплені ним.

5 причин, чому olmOCR перевершує інші інструменти

-

Економічна ефективність, яку важко ігнорувати

Обробляйте 1 мільйон сторінок за $190 — це в 32 рази дешевше, ніж пакетні API GPT-4o. Як? За допомогою точного налаштування на 250 тис. різноманітних сторінок (наукові статті, юридичні документи, навіть рукописні листи) та оптимізації висновків за допомогою SGLang/vLLM.

Обробляйте 1 мільйон сторінок за $190 — це в 32 рази дешевше, ніж пакетні API GPT-4o. Як? За допомогою точного налаштування на 250 тис. різноманітних сторінок (наукові статті, юридичні документи, навіть рукописні листи) та оптимізації висновків за допомогою SGLang/vLLM. -

Магія Markdown Більше ніяких кошмарів з регулярними виразами. olmOCR видає чистий Markdown з:

- Збереженими рівняннями (

E=mc²) - Таблицями, які залишаються таблицями

- Правильним порядком читання для складних макетів

- Збереженими рівняннями (

-

Конвеєр з усіма необхідними компонентами

python -m olmocr.pipeline ./workspace --pdfs your_file.pdfМасштабуйте від 1 до 100+ графічних процесорів без проблем. Вбудована обробка помилок вирішує поширені проблеми PDF, такі як пошкодження метаданих.

-

Відкритий код, нуль чорних ящиків Ваги, навчальні дані (так, усі 250 тис. сторінок!) та код є загальнодоступними. Побудовано на основі Qwen2-VL-7B-Instruct — без пропрієтарних залежностей.

-

Перевага, доведена людьми

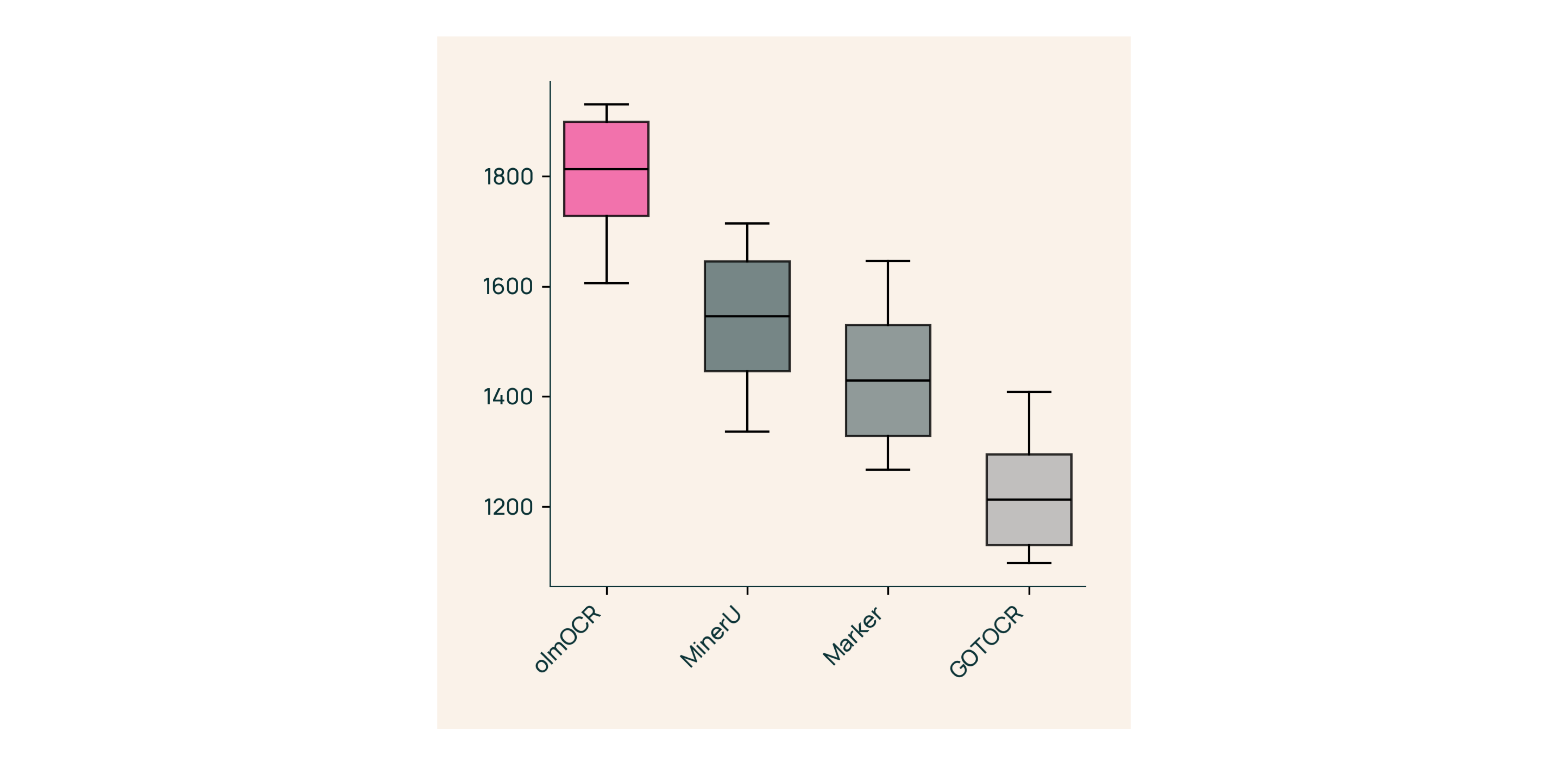

У сліпих тестах проти Marker, GOT-OCR 2.0 та MinerU:

У сліпих тестах проти Marker, GOT-OCR 2.0 та MinerU:- Перемагає у 61% порівнянь

- Досягає ELO >1800 (Золотий стандарт)

Під капотом: як ми створили olmOCR

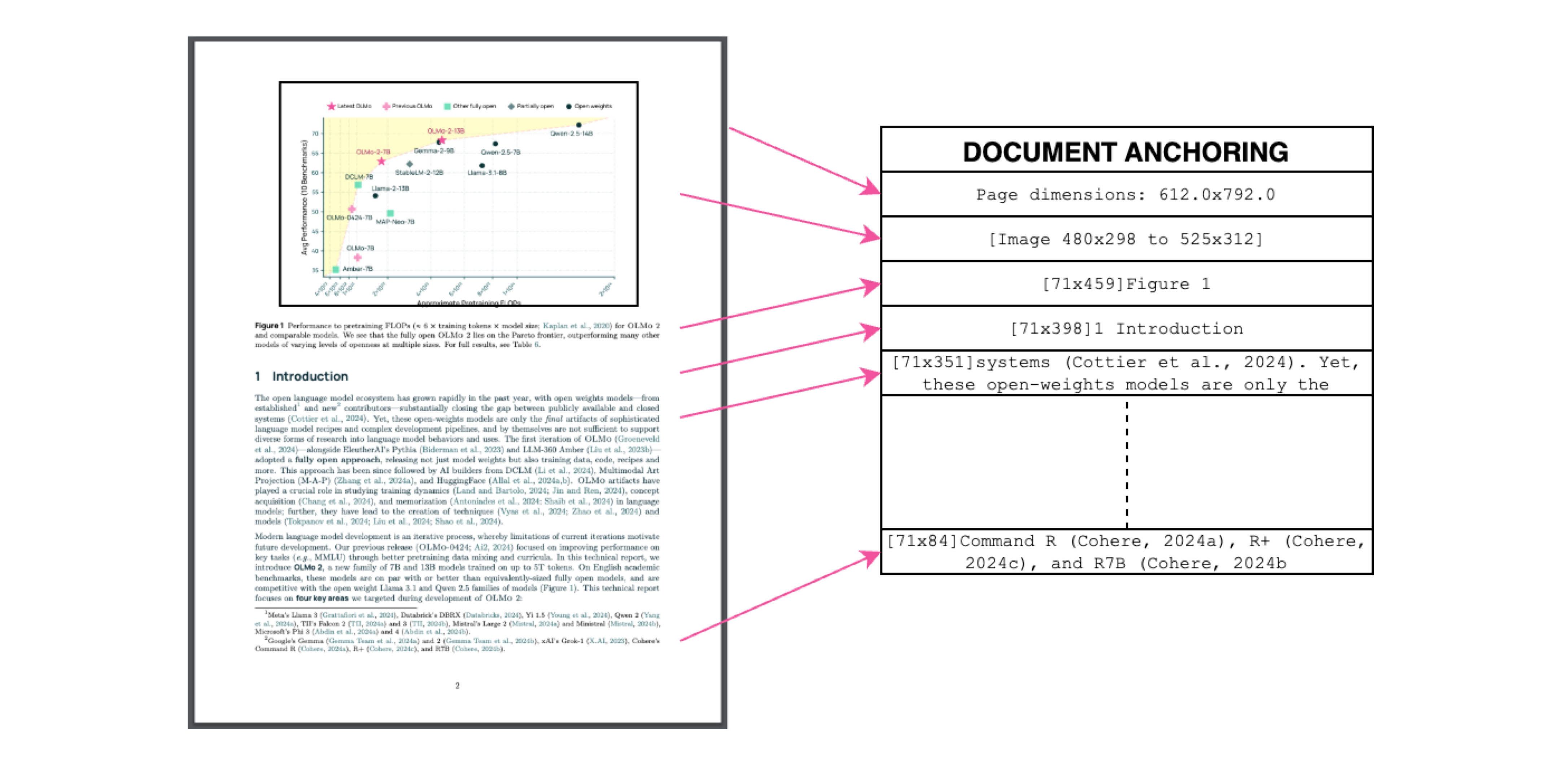

Якоріння документа: секретний соус

Підпис: Контекст тексту + зображення = точне вилучення.

Підпис: Контекст тексту + зображення = точне вилучення.

Ми використовуємо власний текст/метадані PDF для «закріплення» VLM під час навчання:

- Вилучення текстових блоків та областей зображень

- Об'єднання їх у підказки моделі

- Нехай GPT-4o генерує «золотий стандарт» міток

Результат? Модель, яка розуміє як що говорить текст, так і де йому місце.

Навчання для реального світу

- Набір даних: 60% наукових статей, 12% брошур, 11% юридичних документів

- Обладнання: Оптимізовано для графічних процесорів NVIDIA, споживання енергії на 90% нижче, ніж у аналогічних налаштуваннях

- Точне налаштування: Qwen2-VL-7B-Instruct адаптовано для «розмов» з документами

Спробуйте olmOCR за 3 хвилини

- Встановлення

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - Запуск на прикладі PDF

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - Перевірте Markdown

Відкрийте

./demo_output/horribleocr.md— побачите таблиці, рівняння та цілісний потік тексту!

Підсумок

olmOCR — це не просто ще один інструмент, це зміна парадигми. Поєднуючи VLM з прозорою інженерією, він робить високоякісне вилучення тексту доступним для всіх. Незалежно від того, чи створюєте ви дослідницький корпус, чи автоматизуєте обробку рахунків-фактур, цей інструментарій має бути у вашому стеку.

Наступні кроки

- ⭐ Поставте зірку репозиторію GitHub

- 📊 Порівняйте результати за допомогою Інтерактивного інструменту

- 💬 Приєднуйтесь до обговорення на Hugging Face

Перетворимо біль від PDF на просту текстову вигоду! 🚀