利用视觉语言模型高效提取PDF文本 —— olmOCR如何改变游戏规则

OLMOCR Team

2025年3月3日

说明:olmOCR 的端到端流程以 GPT-4o 成本的 1/32 将混乱的 PDF 转换为结构化的 Markdown 文本。

说明:olmOCR 的端到端流程以 GPT-4o 成本的 1/32 将混乱的 PDF 转换为结构化的 Markdown 文本。

PDF 的隐性挑战:纯文本为何重要

语言模型依赖于干净的文本——但 PDF 是终极的“亦敌亦友”。它们专为打印设计,而非解析,会弄乱文本位置,将表格埋在二进制代码中,并将方程式变成视觉难题。传统的 OCR 工具呢?它们经常会遗漏格式,难以处理多列布局,或者收费高昂。

隆重推出 olmOCR:一个开源工具包,它结合了视觉语言模型 (VLM) 和智能工程,以破解 PDF 代码。让我们分解一下为什么开发人员和研究人员对它如此关注。

olmOCR 优于其他工具的 5 大理由

-

难以忽视的成本效益

处理 100 万页只需 190 美元——比 GPT-4o 批量 API 便宜 32 倍。为什么?通过在 25 万页不同的页面(学术论文、法律文件,甚至是手写信件)上进行微调,并使用 SGLang/vLLM 优化推理。

处理 100 万页只需 190 美元——比 GPT-4o 批量 API 便宜 32 倍。为什么?通过在 25 万页不同的页面(学术论文、法律文件,甚至是手写信件)上进行微调,并使用 SGLang/vLLM 优化推理。 -

Markdown 魔法 不再有正则表达式的噩梦。olmOCR 输出干净的 Markdown,具有:

- 保留的方程式(

E=mc²) - 保持表格原样

- 复杂布局的正确阅读顺序

- 保留的方程式(

-

内置流程

python -m olmocr.pipeline ./workspace --pdfs your_file.pdf从 1 个到 100 多个 GPU 无缝扩展。内置的错误处理程序解决了常见的 PDF 问题,如元数据损坏。

-

开源,零黑盒 权重、训练数据(是的,所有 25 万页!)和代码都是公开的。基于 Qwen2-VL-7B-Instruct——没有专有依赖项。

-

经过人类验证的优越性

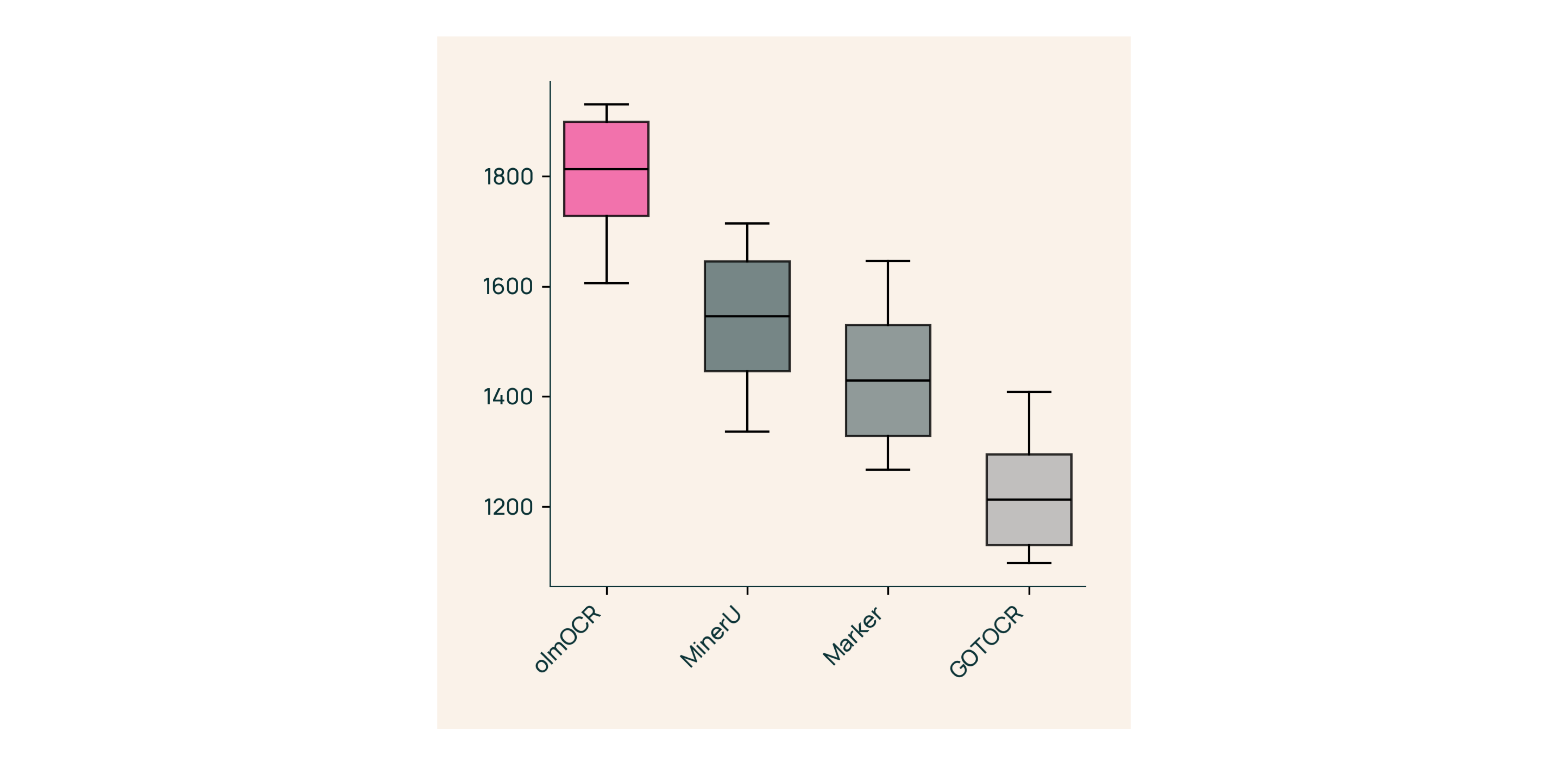

在与 Marker、GOT-OCR 2.0 和 MinerU 的盲测中:

在与 Marker、GOT-OCR 2.0 和 MinerU 的盲测中:- 赢得 61% 的比较

- 达到 ELO >1800(金牌标准)

幕后:我们如何构建 olmOCR

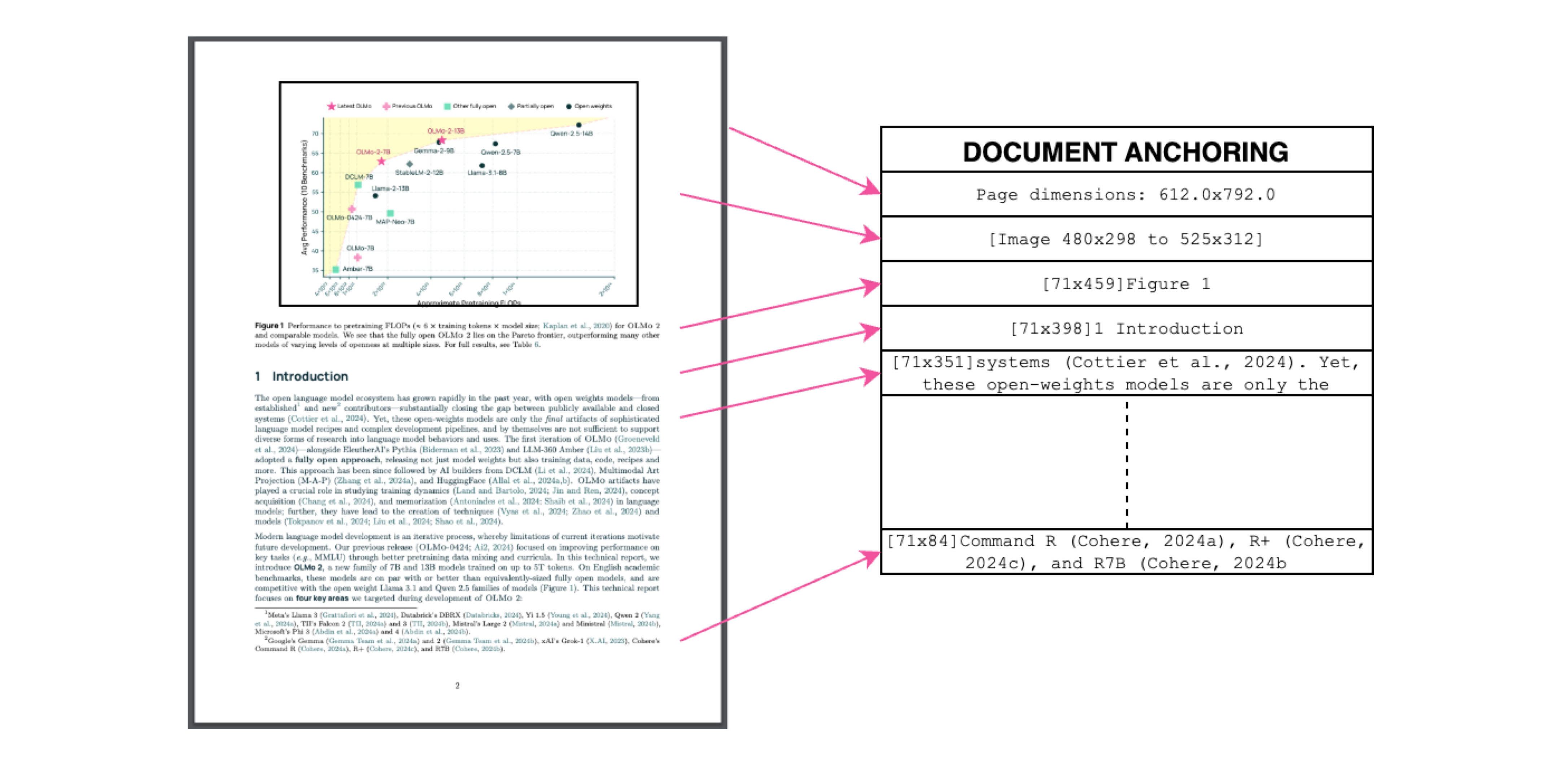

文档锚定:秘密武器

说明:文本 + 图像上下文 = 精确提取。

说明:文本 + 图像上下文 = 精确提取。

我们在训练期间使用 PDF 自己的文本/元数据来“锚定” VLM:

- 提取文本块和图像区域

- 将它们组合在模型提示中

- 让 GPT-4o 生成“黄金标准”标签

结果?一个理解文本 内容 和 位置 的模型。

为真实世界训练

- 数据集:60% 学术论文,12% 宣传册,11% 法律文件

- 硬件:针对 NVIDIA GPU 优化,比同类设置降低 90% 的能耗

- 微调:Qwen2-VL-7B-Instruct 适用于文档“对话”

3 分钟试用 olmOCR

- 安装

git clone https://github.com/allenai/olmocr && cd olmocr pip install -e . - 在示例 PDF 上运行

python -m olmocr.pipeline ./demo_output --pdfs tests/gnarly_pdfs/horribleocr.pdf - 检查 Markdown

打开

./demo_output/horribleocr.md——查看表格、方程式和文本流完好无损!

最终总结

olmOCR 不仅仅是另一个工具——它是一种范式转变。通过将 VLM 与透明的工程相结合,它使每个人都可以获得高质量的文本提取。无论您是构建研究语料库还是自动化发票处理,此工具包都应该在您的堆栈中。

下一步

- ⭐ 给 GitHub 存储库 点赞

- 📊 使用 交互式工具 比较输出

- 💬 加入 Hugging Face 上的讨论

让我们将 PDF 的痛苦转化为纯文本的收益! 🚀